-

×

Personagens Consistentes

1 × R$50.00

Personagens Consistentes

1 × R$50.00

Subtotal: R$50.00

Gerou uma imagem de IA de difusão estável, mas não é bem o que você quer? Neste artigo, vou lhe ensinar algumas técnicas simples de prompt para que você possa discar suas imagens.

Não existem muitos tutoriais para gerar animais. Neste artigo, veremos algumas técnicas para gerar:

Um dos usos mais populares do Stable Diffusion é gerar pessoas realistas. Elas podem parecer tão reais quanto tiradas de uma câmera. Nesta publicação, você aprenderá a mecânica de gerar imagens de retratos no estilo de fotos. Você aprenderá sobre prompts, modelos e upscalers para gerar pessoas realistas.

Stable Diffusion WebUI (AUTOMATIC1111 ou A1111 para abreviar) é a GUI de fato para usuários avançados. Graças à comunidade apaixonada, a maioria dos novos recursos vêm primeiro para esta GUI gratuita do Stable Diffusion. Mas não é o software mais fácil de usar. Falta documentação. A extensa lista de recursos que ele oferece pode ser intimidante.

Este guia lhe ensinará como usar a GUI AUTOTMATIC1111. Você pode usá-lo como um tutorial. Há muitos exemplos que você pode seguir passo a passo.

Você também pode usar este guia como um manual de referência . Pule-o e veja o que há lá. Volte a ele quando realmente precisar usar um recurso.

Você verá muitos exemplos para demonstrar o efeito de uma configuração, porque acredito que essa é a única maneira de deixá-la clara.

Stable Diffusion XL (SDXL) é o mais recente modelo de imagem de IA que pode gerar pessoas realistas, texto legível e diversos estilos de arte com excelente composição de imagem. É uma versão maior e melhor do celebrado modelo Stable Diffusion v1.5 , e daí o nome SDXL.

Conforme descrito no artigo “ SDXL: Melhorando modelos de difusão latente para síntese de imagens de alta resolução ” por Podell e colaboradores, o Stable Diffusion XL é em todos os aspectos melhor que o modelo v1.5.

As melhorias são

Este post abordará:

Desenvolver um processo para construir bons prompts é o primeiro passo que todo usuário do Stable Diffusion enfrenta. Este artigo resume o processo e as técnicas desenvolvidas por meio de experimentações e contribuições de outros usuários. O objetivo é escrever tudo o que sei sobre prompts para que você possa conhecê-los todos em um só lugar.

Não importa quão bons sejam seu prompt e modelo, é raro obter uma imagem perfeita em uma única foto.

Inpainting é uma maneira indispensável de consertar pequenos defeitos. Neste post, vou passar por alguns exemplos básicos de uso de inpainting para consertar defeitos.

Se você é novo em imagens de IA, talvez seja interessante ler primeiro o guia para iniciantes.

Esta é a parte 3 da série do guias para iniciantes.

Leia a parte 1: Guia para iniciantes absolutos

Leia a parte 2: Construção de prompts

Leia a parte 4: Modelos .

Usaremos Stable Diffusion AI e AUTOMATIC1111 GUI. Veja meu guia de início rápido para configuração no servidor de nuvem do Google.

Nesta seção, mostrarei passo a passo como usar o inpainting para corrigir pequenos defeitos.

Usarei uma imagem original do prompt do Lonely Palace :

[emma watson: amber hear: 0,5], (cabelo longo: 0,5), headLeaf, vestindo estola, vasto palácio romano, grande janela, palácio renascentista medieval, ((sala grande)), 4k, arstation, intrincado, elegante, altamente detalhado(Configurações detalhadas podem ser encontradas aqui .)

É uma boa imagem, mas gostaria de corrigir os seguintes problemas

Você sabia que existe um modelo de Difusão Estável treinado para inpainting? Você pode usá-lo se quiser obter o melhor resultado. Mas, normalmente, é OK usar o mesmo modelo com o qual você gerou a imagem para inpainting.

Para instalar o modelo de pintura v1.5 , baixe o arquivo de ponto de verificação do modelo e coloque-o na pasta

stable-diffusion-webui/models/Stable-diffusionNo AUTOMATIC1111, pressione o ícone de atualização ao lado da caixa suspensa de seleção de ponto de verificação no canto superior esquerdo. Selecione sd-v1-5-inpainting.ckptpara habilitar o modelo.

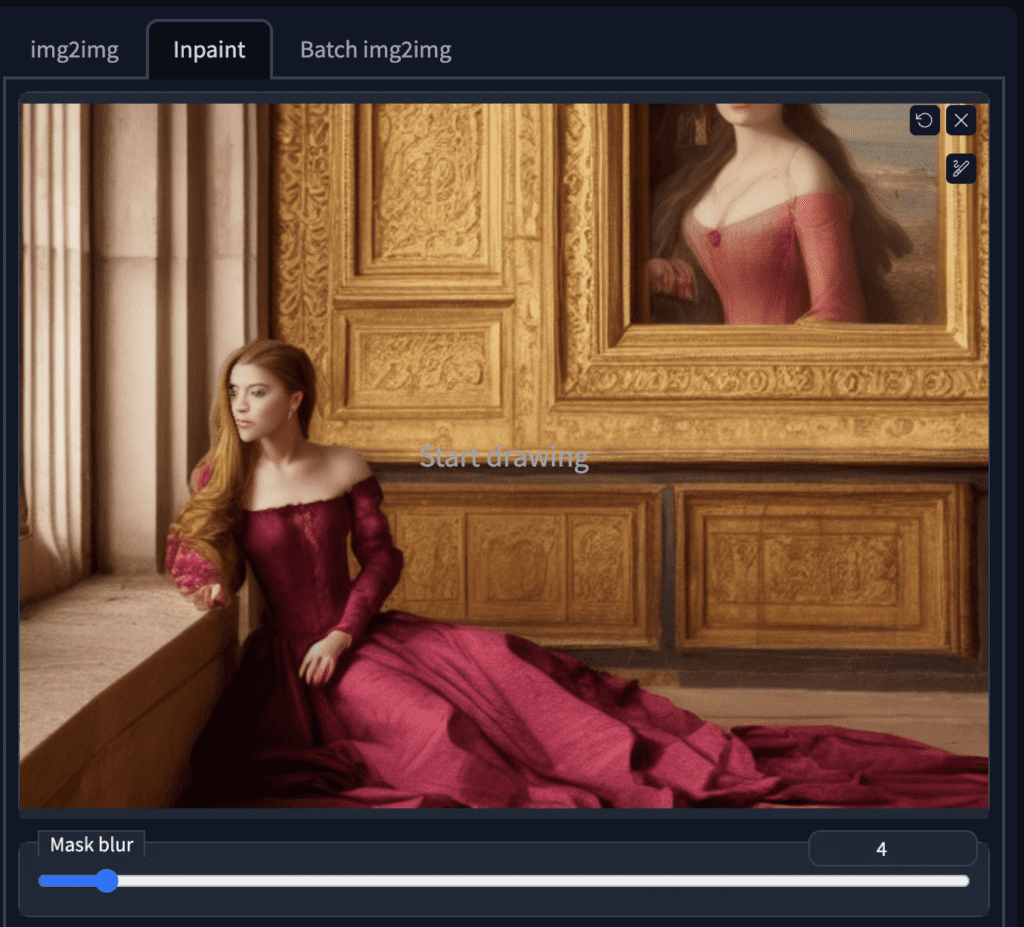

Na GUI do AUTOMATIC1111, selecione a aba img2img e selecione a subaba Inpaint . Carregue a imagem para a tela inpainting.

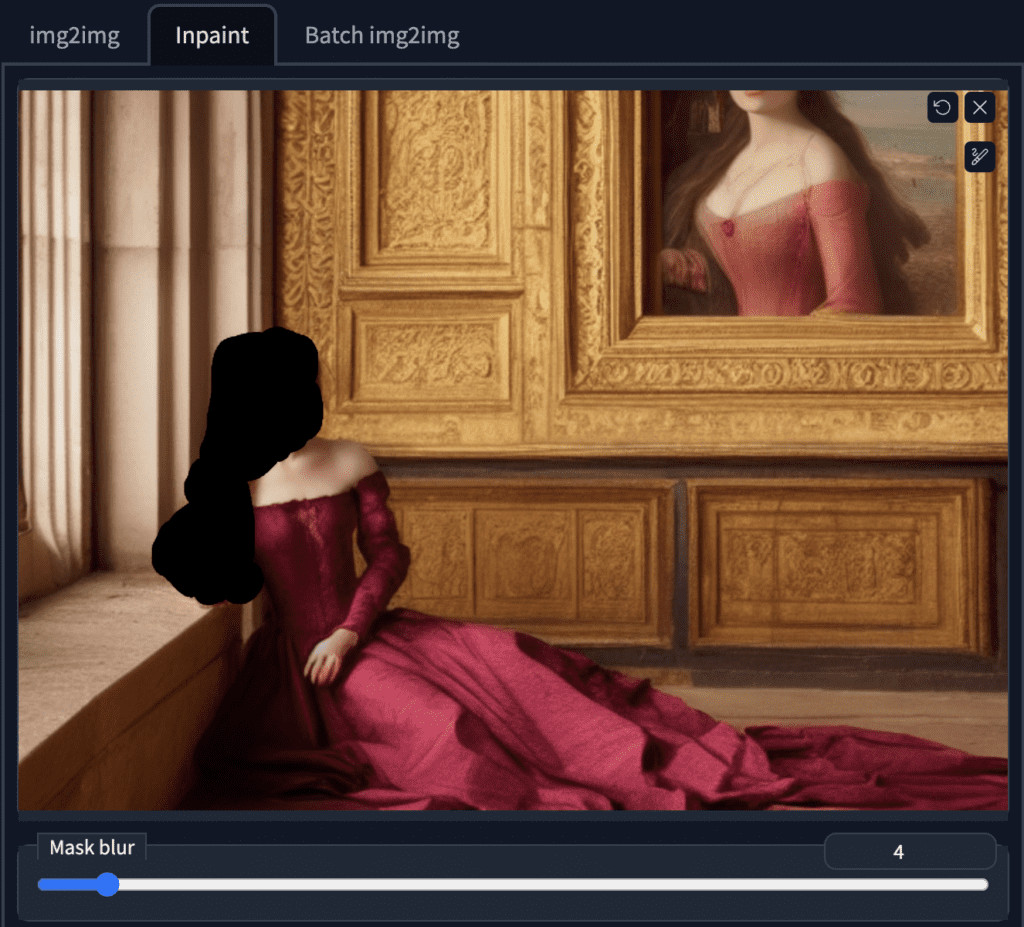

Vamos pintar o braço direito e o rosto ao mesmo tempo. Use a ferramenta pincel para criar uma máscara . Esta é a área em que você quer que o Stable Diffusion regenere a imagem.

Você pode reutilizar o prompt original para corrigir defeitos. Isso é como gerar múltiplas imagens, mas apenas em uma área específica.

O tamanho da imagem precisa ser ajustado para ser o mesmo da imagem original. (704 x 512 neste caso).

Se você estiver pintando rostos, você pode ativar a restauração de rostos . Você também precisará selecionar e aplicar o modelo de restauração de rosto a ser usado na aba Configurações . O CodeFormer é um bom.

Cuidado, pois esta opção pode gerar visuais não naturais. Também pode gerar algo inconsistente com o estilo do modelo.

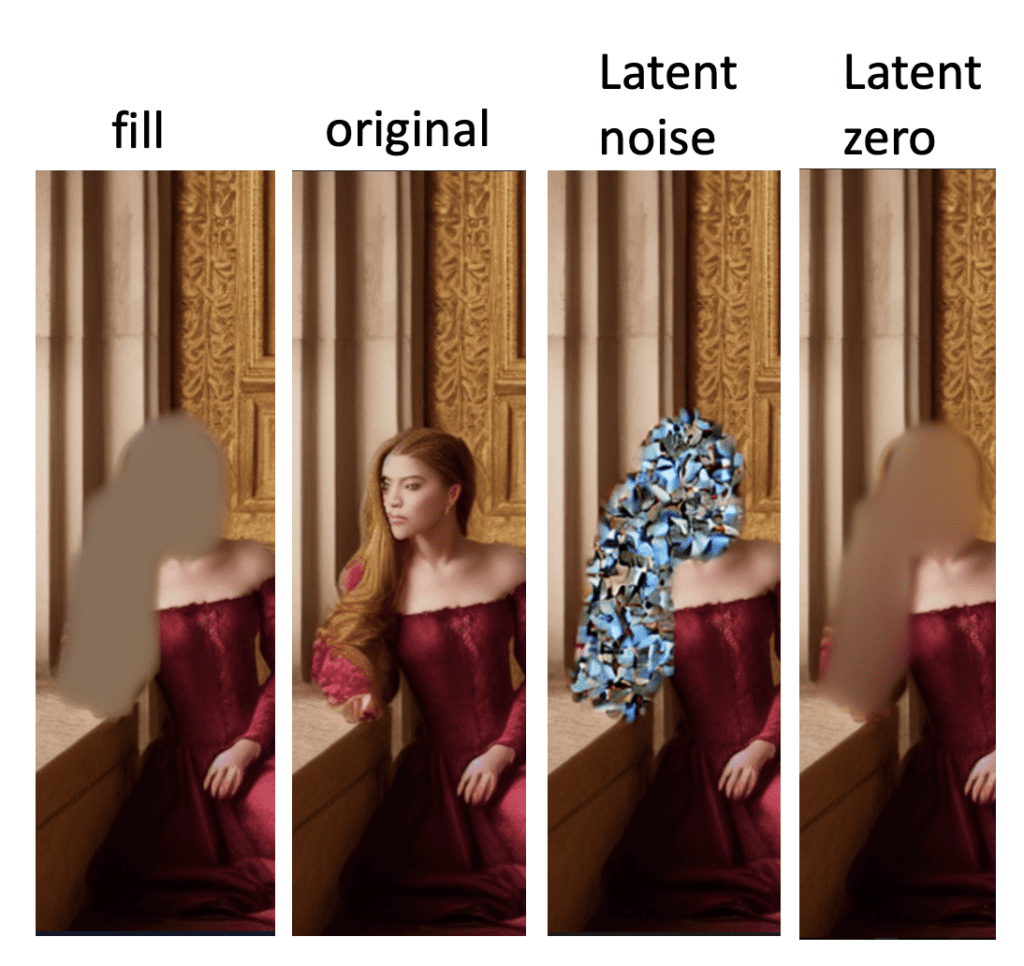

A próxima configuração importante é Conteúdo da Máscara .

Selecione original se quiser que o resultado seja guiado pela cor e forma do conteúdo original. Original é frequentemente usado ao pintar rostos porque a forma geral e a anatomia estavam ok. Queremos apenas que pareça um pouco diferente.

Na maioria dos casos, você usará o Original e alterará a intensidade da redução de ruído para obter efeitos diferentes.

Você pode usar latent noise ou latent nothing se quiser regenerar algo completamente diferente do original, por exemplo, remover um membro ou esconder uma mão. Essas opções inicializam a área mascarada com algo diferente da imagem original. Ela produzirá algo completamente diferente.

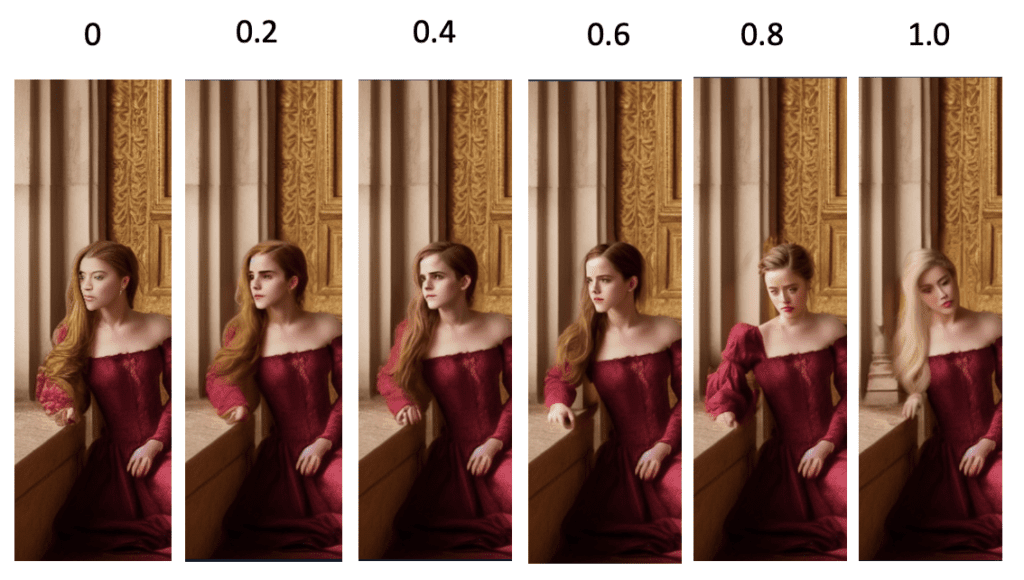

A intensidade do denoising controla quanta mudança ele fará em comparação com a imagem original. Nada mudará quando você definir como 0. Você obterá uma pintura interna não relacionada quando definir como 1.

0,75 geralmente é um bom ponto de partida. Diminua se quiser mudar menos.

Certifique-se de gerar algumas imagens por vez para que você possa escolher as melhores. Defina a semente para -1 para que cada imagem seja diferente.

| Prompt | (Igual ao original) |

| Etapas de amostragem | 20 |

| Seed | -1 |

| Tamanho da imagem | 704 x 512 |

| Restauração facial | Codeformer |

| Método de amostragem | Euler a |

| Modelo | Stable Diffusion v1.5 inpainting |

| Conteúdo da máscara | ruído latente ou nada latente |

| Inpaint em resolução máxima | On |

| Força de redução de ruído | 0,75 |

Abaixo estão algumas das imagens com inpainted aplicado.

Gosto do último, mas há uma mão extra sob o braço recém-pintado. Siga etapas semelhantes de upload desta imagem e criação de uma máscara. O conteúdo mascarado deve ser definido como ruído latente para gerar algo completamente diferente.

A mão sob o braço é removida com a segunda rodada de pintura:

E esta é minha imagem final.

Uma comparação lado a lado

Inpainting é um processo iterativo. Você pode aplicá-lo quantas vezes quiser para refinar uma imagem.

Veja esta postagem para outro exemplo mais extremo de inpainting.

Veja o tutorial para remover membros extras com pintura interna .

Às vezes você quer adicionar algo novo à imagem.

Vamos tentar adicionar um leque à imagem.

Primeiro, carregue a imagem na tela de pintura e crie uma máscara ao redor do peito e do braço direito.

Adicione o prompt “segurando um leque de mão” ao início do prompt original. O prompt para inpainting é

(segurando um leque: 1,2), [emma watson: âmbar ouvido: 0,5], (cabelo longo: 0,5), headLeaf, vestindo estola, vasto palácio romano, grande janela, palácio renascentista medieval, ((sala grande)), 4k, arstation, intrincado, elegante, altamente detalhado

Adicionar novos objetos ao prompt original garante consistência no estilo. Você pode ajustar o peso da palavra-chave (1.2 acima) para fazer o leque aparecer.

Defina o conteúdo mascarado como ruído latente .

Ajuste a intensidade da redução de ruído e a escala CFG para refinar as imagens pintadas.

Depois de alguma experimentação, nossa missão foi cumprida:

A intensidade do denoising controla o quanto a imagem final deve respeitar o conteúdo original. Definindo como 0 não muda nada. Definindo como 1, você tem uma imagem não relacionada.

Defina um valor baixo se quiser uma pequena mudança e um valor alto se quiser uma grande mudança.

Semelhante ao uso em texto para imagem , a escala de Orientação Livre do Classificador é um parâmetro para controlar o quanto o modelo deve respeitar seu prompt.

1 – Ignore principalmente seu prompt.

3 – Seja mais criativo.

7 – Um bom equilíbrio entre seguir o prompt e a liberdade.

15 – Aderir mais ao prompt.

30 – Siga o prompt rigorosamente.

O conteúdo mascarado controla como a área mascarada é inicializada.

Abaixo estão os conteúdos iniciais da máscara antes de quaisquer etapas de amostragem. Isso dá a você uma ideia do que eles são.

A pintura interna bem-sucedida requer paciência e habilidade. Aqui estão algumas dicas para usar a pintura interna

Confira o Curso de Difusão Estável para um curso guiado passo a passo.

Ou continue para a parte 4 abaixo.

Esta é a parte 3 da série de guias para iniciantes.

Leia a parte 1: Guia para iniciantes absolutos .

Leia a parte 2: Construção de prompts .

Leia a parte 4: Modelos .

A construção de prompts é uma habilidade básica que qualquer usuário do Stable Diffusion deve dominar. Ao entender como construir prompts claros e concisos, você pode desbloquear toda a gama de estilos que o Stable Diffusion oferece. Para se destacar na construção de prompts, você deve começar com um assunto específico em mente e adicionar palavras-chave para direcionar para um efeito específico.

A habilidade que você aprenderá neste artigo pode ser aplicada a outros geradores de arte de IA, como o MidJourney.

Esta é a parte 2 da série de guias para iniciantes.

Leia a parte 1: Guia para iniciantes absolutos .

Leia a parte 3: Inpainting .

Leia a parte 4: Modelos .

Se você quiser praticar a construção de prompts, mas ainda não configurou seu Stable Diffusion, você pode usar um gerador de Difusão Estável gratuito online.

Leia o Guia de Início Rápido se quiser configurar o seu próprio.

Use o criador de prompts para uma abordagem sistemática para criar prompts.

Este post pretende ser seu primeiro curso de prompting. Veja este guia de prompt para técnicas avançadas.

Esta é uma técnica comprovada para gerar imagens específicas de alta qualidade. Seu prompt deve cobrir a maioria, se não todas, dessas áreas.

Primeiro, você precisará de uma descrição do assunto com o máximo de detalhes possível. Abaixo está um exemplo.

Prompt (somente assunto):

Uma jovem mulher com vestido azul claro sentada ao lado de uma janela de madeira lendo um livro.

Um erro comum de um iniciante é não descrever a imagem com detalhes suficientes . Que roupa ela usa? Qual é o penteado dela? Esses elementos aparentemente menores podem contribuir significativamente para a imagem geral que está sendo transmitida. Sem especificar esses detalhes, você os deixa abertos para o gerador de IA e pode ficar desapontado com o que obtém.

É uma boa prática incluir um prompt negativo genérico.

feio, deformado, desfigurado

Vamos usar o modelo Realistic Vision v2 .

Obtivemos a seguinte imagem, que corresponde muito bem ao prompt.

Podemos ser mais específicos. Vamos adicionar um meio , o material em que a obra de arte é criada. Alguns exemplos são pintura digital , fotografia e pintura a óleo . Vamos usar

Medium

Pintura digital

O novo prompt é

Pintura digital de uma jovem com vestido azul claro sentada ao lado de uma janela de madeira lendo um livro

A imagem resultante é

Você pode ver a imagem mudar de uma fotografia para uma arte digital. É um passo à frente, mas podemos fazer melhor.

Você entendeu a ideia. Vamos adicionar o resto deles

Artist– especificando o artista que criou a arte para orientar o estilo.

por Stanley Artgerm Lau

Website– O nome do site pode ser usado para um gênero específico.

artstation

Resolution– São palavras-chave que controlam a nitidez da imagem.

8k

Additional details– Estas são palavras-chave que são mais como adoçantes, por exemplo, adicionando alguns detalhes interessantes.

extremamente detalhado, ornamentado

Lighting– Controlar a luz é importante para uma boa imagem.

iluminação cinematográfica, iluminação de borda

color– O esquema de cores da imagem

vívido

Colocando tudo junto, o prompt é

Pintura digital de uma jovem mulher com vestido azul claro sentada ao lado de uma janela de madeira lendo um livro, por Stanley Artgerm Lau, artstation, 8k, extremamente detalhado, ornamentado, iluminação cinematográfica, iluminação de borda, vívido

Agora temos esta imagem.

Podemos projetar a imagem para obter o estilo desejado adicionando palavras-chave específicas ao prompt.

Abaixo estão algumas das minhas palavras-chave favoritas e seus efeitos. (Usado com Stable Diffusion v1.4 e v1.5 ). Aproveite!

Você pode encontrar a lista completa no construtor de prompts .

Gerador de prompt passo a passo para criar prompts de alta qualidade.

O meio define uma categoria de obra de arte.

| palavra-chave | Observação |

|---|---|

| Retrato | Desenhos muito realistas. Bom para usar com pessoas. |

| Pintura digital | Estilo de arte digital. |

| Arte conceitual | Estilo de ilustração, 2D. |

| Ilustração ultra realista | Desenhos muito realistas. Bom para usar com pessoas. |

| Retrato subaquático | Use com pessoas. Embaixo d’água. Cabelo flutuando. |

| Steampunk subaquático | Desenhos muito realistas. Bom para usar com pessoas. |

Essas palavras-chave refinam ainda mais o estilo de arte.

| palavra-chave | Observação |

|---|---|

| hiperrealista | Aumenta os detalhes e a resolução |

| arte pop | Estilo pop art |

| Modernista | cor vibrante, alto contraste |

| arte nova | Adicione ornamentos e detalhes, estilo de construção |

Mencionar o artista no prompt é um efeito forte. Estude o trabalho dele e escolha sabiamente.

| palavra-chave | Observação |

|---|---|

| João Collier | Pintor de retratos do século XIX. Adicione elegância |

| Stanley Artgerm Lau | Bom para usar com retratos de mulheres, gerar roupas delicadas do século XIX, algum impressionismo |

| Frida Kahlo | Efeito bastante forte seguindo o estilo de retrato de Kahlo. Às vezes resulta em moldura de imagem |

| John Cantor Sargento | Bom para usar com retratos de mulheres, gerar roupas delicadas do século XIX, algum impressionismo |

| Alfonso Mucha | Pintura de retrato 2D no estilo de Alphonse Mucha |

Mencionar um site de arte ou fotografia tem um efeito forte, provavelmente porque cada site tem seu gênero de nicho.

| palavra-chave | Observação |

|---|---|

| pixiv | Estilo anime japonês |

| pixabay | Estilo de fotografia comercial |

| artstation | Ilustração moderna, fantasia |

| palavra-chave | Observação |

|---|---|

| unreal engine | 3D muito realista e detalhado |

| foco nítido | Aumentar a resolução |

| 8k | Aumentar a resolução, embora possa fazer com que pareça mais falso. Torna a imagem mais parecida com a de uma câmera e mais realista |

| muito | Renderização 3D ideal para objetos, paisagens e construções. |

| palavra-chave | Observação |

|---|---|

| iluminação de borda | luz na borda de um objeto |

| iluminação cinematográfica | Um termo genérico para melhorar o contraste usando luz |

| raios crepusculares | luz do sol rompendo a nuvem |

Adicione detalhes específicos à sua imagem.

| palavra-chave | Observação |

|---|---|

| dramático | filmado de um ângulo baixo |

| seda | Adicione seda à roupa |

| expansivo | Fundo mais aberto, assunto menor |

| foto em ângulo baixo | foto tirada de um ângulo baixo |

| raios de deus | luz do sol rompendo a nuvem |

| psicodélico | cor viva com distorção |

Adicione um esquema de cores adicional à imagem.

| palavra-chave | Observação |

|---|---|

| ouro iridescente | Ouro brilhante |

| prata | Cor prata |

| vintage | efeito vintage |

Passamos pela estrutura básica de um bom prompt. Isso deve ser usado como um guia e não como uma regra. O modelo Stable Diffusion é muito flexível. Deixe-o surpreender você com alguma combinação criativa de palavras-chave!

Confira o Curso de Difusão Estável para um curso guiado passo a passo.

Ou continue para a parte 3 abaixo.

Esta é a parte 2 da série de guias para iniciantes.

Leia a parte 1: Guia para iniciantes absolutos .

Leia a parte 3: Inpainting .

Leia a parte 4: Modelos .

Quer aprender Stable Diffusion AI? Este guia para iniciantes é destinado aos novatos e sem experiência com Stable Diffusion, Flux ou outros geradores de imagem por IA. Ele dará a você uma visão geral do Stable Diffusion/Flux AI e por onde começar.

Esta é a primeira parte da série de guias para iniciantes.

Leia a parte 2: Construção de prompts .

Leia a parte 3: Pintura interna.

Leia a parte 4: Modelos.

Stable Diffusion AI é um modelo de difusão latente para gerar imagens de IA. As imagens podem ser foto realistas, como aquelas capturadas por uma câmera, ou artísticas, como se fossem produzidas por um artista profissional.

A melhor parte é que ele é gratuito. Você pode executá-lo no seu PC ou pode usá-lo online por uma taxa.

Falarei sobre as opções para usar Stable Diffusion e Flux na parte final deste artigo. Mas se você não puder esperar, pegue o Guia de Início Rápido no Stable Diffusion e mergulhe de cabeça.

Tudo o que você precisa é de um prompt que descreva uma imagem . Por exemplo:

casa de gengibre, diorama, em foco, fundo branco, torrada, cereal crocante

A Difusão Estável transforma esse prompt em imagens como as abaixo.

Você pode gerar quantas variações quiser a partir do mesmo prompt.

Existem serviços de geração de texto para imagem semelhantes, como o DALLE e o MidJourney da OpenAI . Por que Stable Diffusion? As vantagens do Stable Diffusion AI são:

O Stable Diffusion é gratuito para uso quando executado em suas próprias máquinas Windows ou Mac . Um serviço online custará uma taxa modesta.

Há muitas maneiras de usar modelos de IA de difusão estável e fluxo. Você precisa decidir:

Para iniciantes absolutos, recomendo usar um gerador online gratuito . Você pode começar a gerar sem o incômodo de configurar as coisas.

Gere algumas imagens e veja se a IA é sua praia.

A melhor opção de PC é executar o Windows com uma placa GPU Nvidia . A maioria dos modelos de IA são otimizados para GPUs Nvidia. As GPUs AMD estão começando a ganhar força, mas espere passar por obstáculos para usá-las. Quanto mais VRAM sua GPU tiver, menos problemas você precisará

Você precisa de um Apple Silicon (M1/M2/M3/M4) para rodar em um Mac.

A desvantagem dos geradores online gratuitos é que as funcionalidades são bastante limitadas.

Use uma GUI (Graphical User Interface) avançada se você já não as usa mais. Uma gama completa de ferramentas está à sua disposição. Para citar algumas:

As GUIs mais populares são:

Consulte o Guia de início rápido para configurá-los localmente ou no Google Colab.

O uso mais básico do Stable Diffusion é texto para imagem (txt2img). Aqui estão alguns exemplos de imagens que você pode gerar com o Stable Diffusion.

Aprenda a gerar pessoas realistas e humanos de rua realistas .

Aprenda a gerar animais .

Guia do iniciante – Stable Diffusion (2ª edição)

Elimine as suposições para se tornar um artista de IA. Aprenda Stable Diffusion passo a passo.

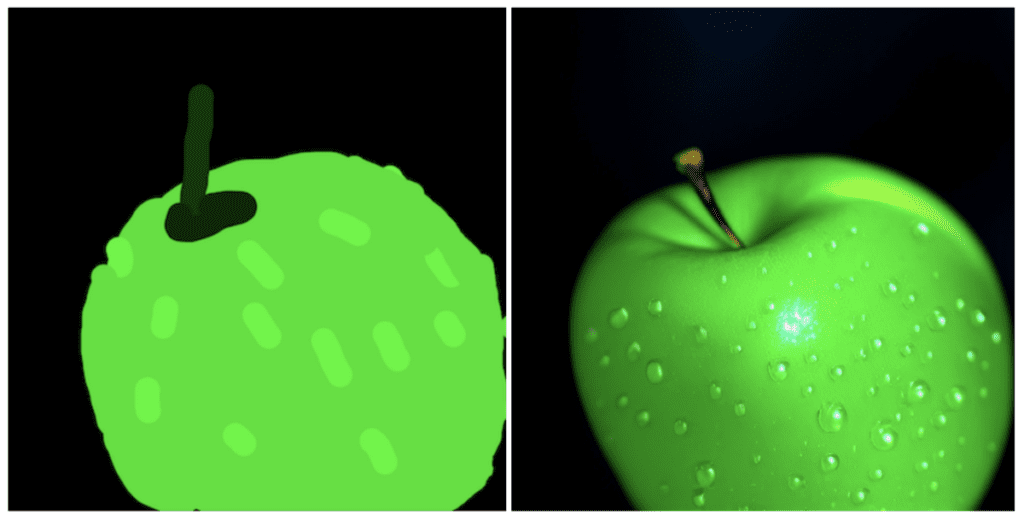

Imagem para imagem (img2img) transforma uma imagem em outra usando IA de difusão estável.

Abaixo está um exemplo de como transformar meu desenho de uma maçã em um desenho foto realista. ( Tutorial )

Você pode usar inpainting para regenerar parte de uma imagem real ou de IA . Isso é o mesmo que a nova função de preenchimento generativo do Photoshop, mas grátis.

Existem duas maneiras principais de fazer vídeos com Stable Diffusion: (1) a partir de um prompt de texto e (2) a partir de outro vídeo.

Deforum é uma maneira popular de fazer um vídeo a partir de um prompt de texto. Você provavelmente já viu um deles nas mídias sociais. Parece com isso:

A segunda maneira é estilizar um vídeo usando Stable Diffusion. Veja o tutorial de vídeo para vídeo .

Este é um tópico mais avançado. É melhor dominar texto para imagem e imagem para imagem antes de mergulhar nele.

Há muito o que aprender para elaborar um bom prompt . Mas o básico é descrever seu assunto com o máximo de detalhes possível. Certifique-se de incluir palavras-chave poderosas para definir o estilo.

Usar um gerador de prompts é uma ótima maneira de aprender um processo passo a passo e palavras-chave importantes. É essencial para iniciantes aprender um conjunto de palavras-chave poderosas e seus efeitos esperados. Isso é como aprender vocabulário para um novo idioma. Você também pode encontrar uma pequena lista de palavras-chave e notas aqui .

Um atalho para gerar imagens de alta qualidade é reutilizar prompts existentes. Vá para a coleção de prompts, escolha uma imagem que você goste e roube o prompt! A desvantagem é que você pode não entender por que ele gera imagens de alta qualidade. Leia as notas e altere o prompt para ver o efeito.

Como alternativa, use sites de coleta de imagens como o PlaygroundAI . Escolha uma imagem que você goste e remixe o prompt. Mas pode ser como encontrar uma agulha em um palheiro para um prompt de alta qualidade.

Trate o prompt como um ponto de partida. Modifique para atender às suas necessidades.

Duas regras: (1) Seja detalhado e específico e (2) use palavras-chave poderosas.

Embora a IA avance a passos largos, a Stable Diffusion ainda não consegue ler sua mente. Você precisa descrever sua imagem com o máximo de detalhes possível.

Digamos que você queira gerar uma imagem de uma mulher em uma cena de rua. Um prompt simplista uma mulher na rua fornece uma imagem como esta:

Bem, você pode não querer gerar uma avó, mas isso tecnicamente corresponde ao seu prompt. Você não pode culpar a Stable Diffusion…

Então, em vez disso, você deveria escrever mais.

uma jovem senhora, olhos castanhos, mechas no cabelo, sorriso, vestindo traje casual de negócios elegante, sentada do lado de fora, rua tranquila da cidade, iluminação de borda

Veja a diferença drástica. Então trabalhe em suas habilidades de construção de prompts !

Algumas palavras-chave são mais poderosas do que outras. Exemplos são

Usá-los com cuidado pode direcionar a imagem na direção desejada.

Você pode aprender mais sobre a criação de prompts e exemplos de palavras-chave em Noções básicas sobre a criação de prompts .

Quer trapacear? Assim como fazer lição de casa, você pode usar o ChatGPT para gerar prompts!

A maioria dos geradores online permite que você altere um conjunto limitado de parâmetros. Abaixo estão alguns importantes:

Veja recomendações para outras configurações .

Você deve sempre gerar várias imagens ao testar um prompt.

Eu gero de 2 a 4 imagens por vez ao fazer grandes mudanças no prompt para que eu possa acelerar a busca. Eu geraria 4 por vez ao fazer pequenas mudanças para aumentar a chance de ver algo utilizável.

Alguns prompts funcionam apenas metade do tempo ou menos. Então, não descarte um prompt com base em uma imagem.

Quando você vê imagens de IA impressionantes compartilhadas em mídias sociais, há uma boa chance de que elas tenham passado por uma série de etapas de pós-processamento. Vamos abordar algumas delas nesta seção.

É bem conhecido na comunidade de artistas de IA que Stable Diffusion não é bom em gerar rostos. Muitas vezes, os rostos gerados têm artefatos.

Frequentemente usamos modelos de IA de imagem que são treinados para restaurar faces, por exemplo, CodeFormer , que AUTOMATIC1111 GUI tem suporte integrado. Veja como ativá-lo .

Você sabia que há uma atualização para os modelos v1.4 e v1.5 para consertar os olhos? Veja como instalar um VAE .

É difícil obter a imagem que você quer na primeira tentativa. Uma abordagem melhor é gerar uma imagem com boa composição. Então repare os defeitos com inpainting .

Abaixo está um exemplo de uma imagem antes e depois do inpainting. Usar o prompt original para inpainting funciona 90% das vezes.

Existem outras técnicas para consertar as coisas. Leia mais sobre como consertar problemas comuns .

Os modelos oficiais lançados pela Stability AI e seus parceiros são chamados de modelos base . Alguns exemplos de modelos base são Stable Diffusion 1.4 , 1.5 , 2.0 e 2.1 .

Modelos personalizados são treinados a partir dos modelos base. Atualmente, a maioria dos modelos é treinada a partir da v1.4 ou v1.5. Eles são treinados com dados adicionais para gerar imagens de estilos ou objetos específicos.

Somente o céu é o limite quando se trata de modelos personalizados. Pode ser estilo anime, estilo Disney ou o estilo de outra IA. Você escolhe.

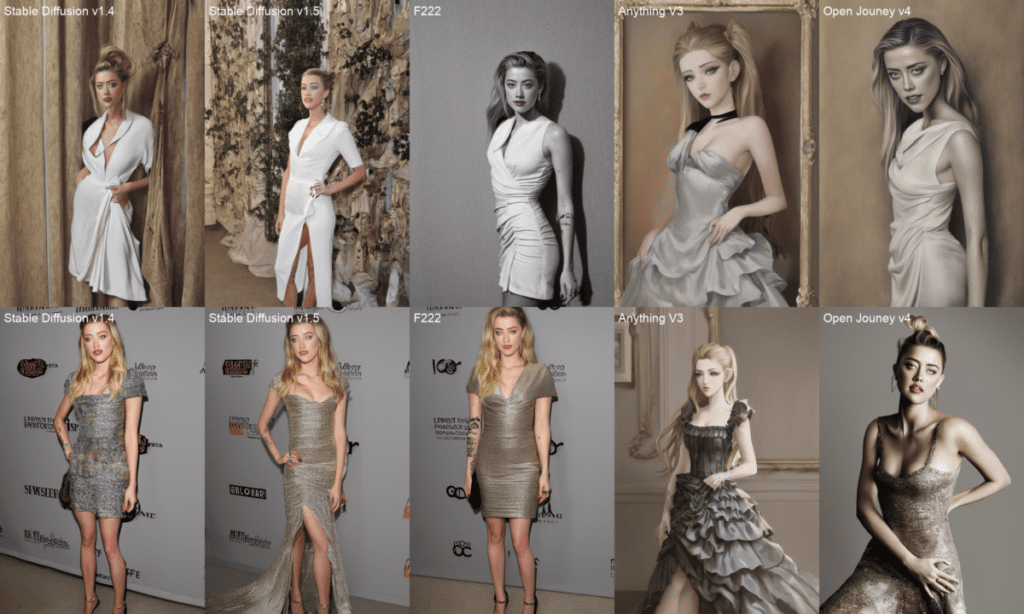

Abaixo está uma comparação de 5 modelos diferentes.

Também é fácil mesclar dois modelos para criar um estilo intermediário.

Fique com os modelos básicos se estiver começando. Há muitos para aprender e brincar para mantê-lo ocupado por meses.

As três versões principais do Stable Diffusion são v1, v2 e Stable Diffusion XL (SDXL).

Você pode pensar que deveria começar com os modelos v2 mais novos. As pessoas ainda estão tentando descobrir como usar os modelos v2. Imagens do v2 não são necessariamente melhores que as do v1.

Houve uma série de modelos SDXL lançados: SDXL beta , SDXL 0.9 e o mais recente SDXL 1.0.

Recomendo usar os modelos v1.5 e SDXL 1.0 se você for novo no Stable Diffusion.

Uma vantagem de usar Stable Diffusion é que você tem controle total do modelo. Você pode criar seu próprio modelo com um estilo único se quiser. Duas maneiras principais de treinar modelos: (1) Dreambooth e (2) embedding .

O Dreambooth é considerado mais poderoso porque ele ajusta o peso de todo o modelo. Os embeddings deixam o modelo intocado, mas encontram palavras-chave para descrever o novo assunto ou estilo.

Você pode experimentar o caderno Colab no artigo do dreambooth .

Você coloca o que quer ver no prompt. Você coloca o que não quer ver no prompt negativo. Nem todos os serviços de Stable Diffusion suportam prompts negativos. Mas é valioso para modelos v1 e essencial para modelos v2. Não faz mal para um iniciante usar um prompt negativo universal. Leia mais sobre prompts negativos:

A resolução nativa do Stable Diffusion é 512×512 pixels para modelos v1. Você NÃO deve gerar imagens com largura e altura que desviem muito de 512 pixels. Use as seguintes configurações de tamanho para gerar a imagem inicial.

Se você definir a largura e a altura iniciais muito altas, verá assuntos duplicados.

O próximo passo é aumentar a escala da imagem. A GUI AUTOMATIC1111 gratuita vem com alguns upscalers de IA populares.

A tecnologia Stable Diffusion está melhorando rapidamente. Existem algumas maneiras.

Você pode pedir ao Stable Diffusion para seguir aproximadamente uma imagem de entrada ao gerar uma nova. É chamado de imagem para imagem . Abaixo está um exemplo de uso de uma imagem de entrada de uma águia para gerar um dragão. A composição da imagem de saída segue a entrada.

O ControlNet usa similarmente uma imagem de entrada para direcionar a saída. Mas ele pode extrair informações específicas, por exemplo, poses humanas. Abaixo está um exemplo de uso do ControlNet para copiar uma pose humana da imagem de entrada.

Além de poses humanas, o ControlNet pode extrair outras informações, como contornos.

Você pode especificar prompts para certas partes de imagens usando uma extensão chamada Regional Prompter . Essa técnica é muito útil para desenhar objetos somente em certas partes da imagem.

Abaixo está um exemplo de como colocar um lobo no canto inferior esquerdo e caveiras no canto inferior direito.

Leia o tutorial do Regional Prompter para saber mais sobre como usá-lo.

Depth-to-image é outra maneira de controlar a composição por meio de uma imagem de entrada. Ele pode detectar o primeiro plano e o segundo plano da imagem de entrada. A imagem de saída seguirá o mesmo primeiro plano e segundo plano. Abaixo está um exemplo.

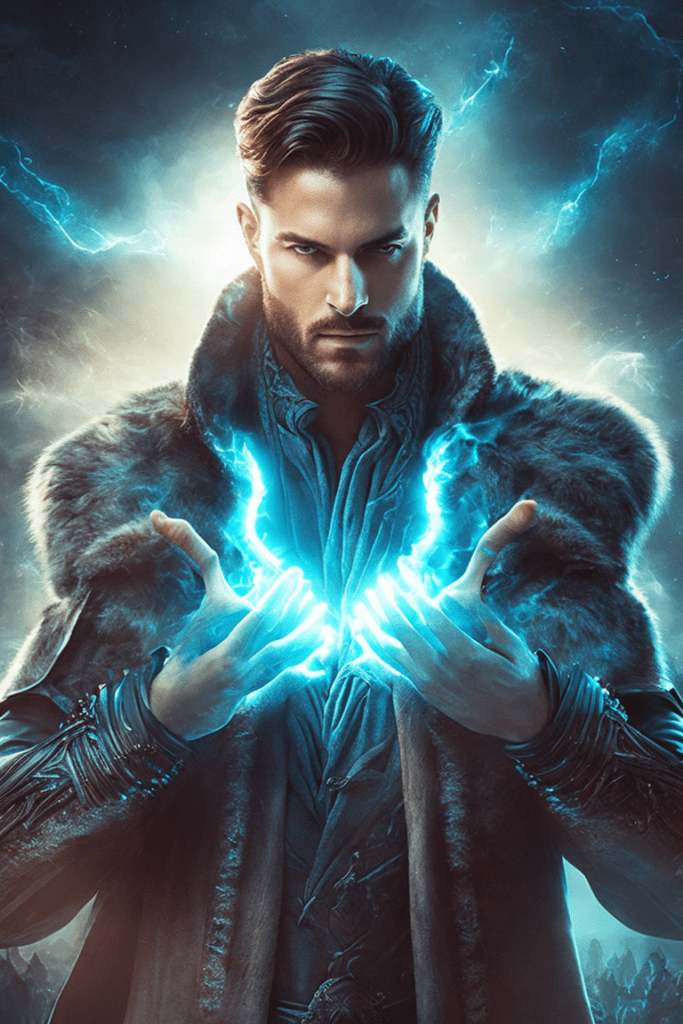

Você pode usar Stable Diffusion para gerar pessoas realistas em estilo de foto. Vamos ver alguns exemplos.

Tudo se resume a usar o prompt certo e um modelo especial treinado para produzir humanos realistas no estilo de foto. Aprenda mais no tutorial para gerar pessoas realistas .

Animais são temas populares entre os usuários do Stable Diffusion.

Aqui estão alguns exemplos.

Leia o tutorial para gerar animais para aprender como.

Unstable Diffusion é uma empresa que desenvolve modelos de Stable Diffusion para pornografia de IA. Eles viraram manchetes quando sua campanha de arrecadação de fundos no Kickstarter foi encerrada . Até agora, eles não divulgaram nenhum modelo publicamente.

A empresa não tem relação com a Stability AI, a empresa que lançou o Stable Diffusion AI.

Então, você concluiu o primeiro tutorial do Guia do Iniciante!

Confira o Curso de Difusão Estável para um curso guiado passo a passo.

Ou continue para a parte 2 abaixo.

Esta é a parte 1 da série de guias para iniciantes.

Leia a parte 2: Construção de prompts .

Leia a parte 3: Pintura interna.

Leia a parte 4: Modelos .