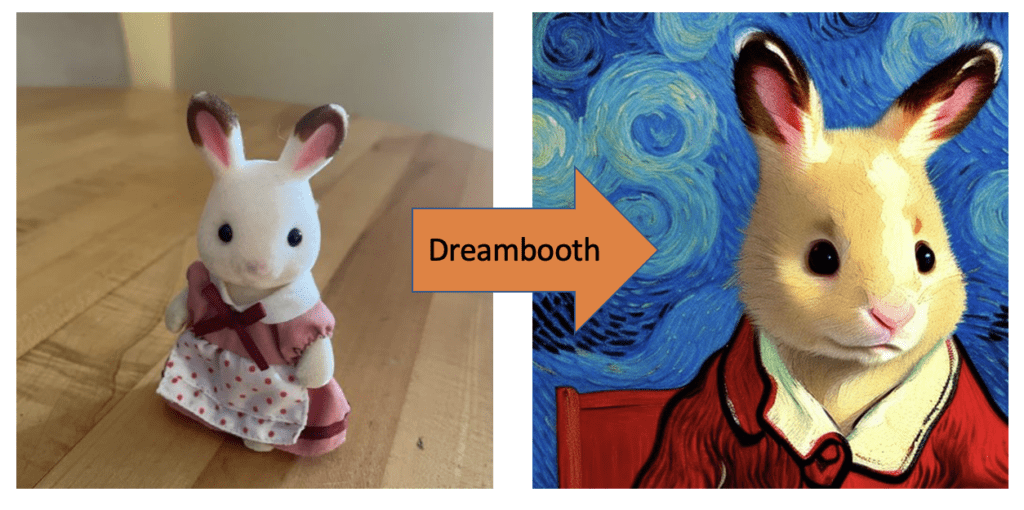

Dreambooth é uma maneira de colocar qualquer coisa — seu ente querido, seu cachorro, seu brinquedo favorito — em um modelo de Stable Diffusion. Apresentaremos o que é Dreambooth, como ele funciona e como executar o treinamento.

Este tutorial é destinado a pessoas que já usaram o Stable Diffusion, mas nunca usaram o Dreambooth antes.

Você seguirá o guia passo a passo para preparar suas imagens de treinamento e usar nosso notebook Colab fácil de 1 clique para treinamento dreambooth. Nenhuma codificação é necessária!

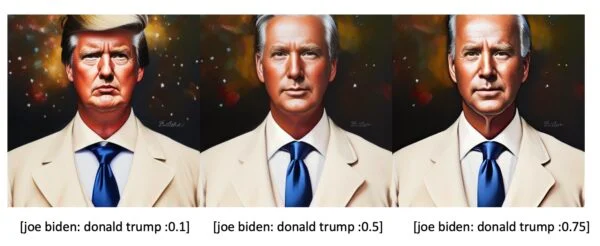

Você pode colocar objetos ou pessoas da vida real em um modelo de Difusão Estável e gerar imagens em diferentes estilos e configurações.

Stable Diffusion - Nível 1

1 × R$50.00

Stable Diffusion - Nível 1

1 × R$50.00 Stable Diffusion - Nível 2

1 × R$50.00

Stable Diffusion - Nível 2

1 × R$50.00 Personagens Consistentes

1 × R$50.00

Personagens Consistentes

1 × R$50.00