-

×

Estilos de Prompts para Stable Diffusion: Lista Completa para Criações Incríveis

1 × R$50.00

Estilos de Prompts para Stable Diffusion: Lista Completa para Criações Incríveis

1 × R$50.00 -

×

Guia de solução de problemas

1 × R$50.00

Guia de solução de problemas

1 × R$50.00

Subtotal: R$100.00

Transformar vídeos em animação nunca foi tão fácil com o Stable Diffusion AI. Você encontrará guias passo a passo para 5 técnicas de vídeo para vídeo neste artigo. O melhor de tudo: você pode executá-los GRATUITAMENTE na sua máquina local!

Todos eles usam uma abordagem semelhante de transformar cada quadro de vídeo individualmente com a ajuda do ControlNet .

No final do artigo, examinarei outros métodos de vídeo para vídeo para difusão estável.

Agora você verá um vídeo de amostra de cada método. Abaixo está o vídeo original.

Um problema comum em imagens de IA de difusão estável é que os membros podem não ser gerados corretamente. Às vezes, uma pessoa pode ter um braço a mais e, em outras ocasiões, uma de suas pernas pode estar faltando. Finalmente, obtivemos 4 membros, mas a anatomia não está correta.

Um leitor sugeriu fazer um tutorial especial para remover membros extras. Então aqui vai! Neste post, mostrarei como usar inpainting para consertar essas duas imagens com membros problemáticos.

Não existem muitos tutoriais para gerar animais. Neste artigo, veremos algumas técnicas para gerar:

Um dos usos mais populares do Stable Diffusion é gerar pessoas realistas. Elas podem parecer tão reais quanto tiradas de uma câmera. Nesta publicação, você aprenderá a mecânica de gerar imagens de retratos no estilo de fotos. Você aprenderá sobre prompts, modelos e upscalers para gerar pessoas realistas.

Um prompt simples para gerar algumas pessoas realistas da cidade.

ComfyUI é uma GUI baseada em nó para Stable Diffusion. Este tutorial é para alguém que nunca usou o ComfyUI antes. Vou cobrir

O Stable Diffusion WebUI Forge (SD Forge) é uma versão alternativa do Stable Diffusion WebUI que apresenta geração de imagem mais rápida para GPUs com baixa VRAM, entre outras melhorias.

Este tutorial é para instalar o SD Forge, uma GUI avançada para Stable Diffusion. Confira o Guia de Início Rápido e considere fazer os Cursos de Stable Diffusion se você for novo no Stable Diffusion.

Este tutorial abrange

Stable Diffusion WebUI (AUTOMATIC1111 ou A1111 para abreviar) é a GUI de fato para usuários avançados. Graças à comunidade apaixonada, a maioria dos novos recursos vêm primeiro para esta GUI gratuita do Stable Diffusion. Mas não é o software mais fácil de usar. Falta documentação. A extensa lista de recursos que ele oferece pode ser intimidante.

Este guia lhe ensinará como usar a GUI AUTOTMATIC1111. Você pode usá-lo como um tutorial. Há muitos exemplos que você pode seguir passo a passo.

Você também pode usar este guia como um manual de referência . Pule-o e veja o que há lá. Volte a ele quando realmente precisar usar um recurso.

Você verá muitos exemplos para demonstrar o efeito de uma configuração, porque acredito que essa é a única maneira de deixá-la clara.

Stable Diffusion XL (SDXL) é um modelo totalmente novo com desempenho sem precedentes. Devido ao seu tamanho maior, o próprio modelo base pode gerar uma ampla gama de estilos diversos.

O que é melhor? Agora você pode usar o ControlNet com o modelo SDXL!

Nota: Este tutorial é para usar o ControlNet com o modelo SDXL. Não vou repetir o uso básico do ControlNet aqui. Veja o guia ControlNet para o uso básico do ControlNet com os modelos v1.

Este guia abrange

ControlNet é uma rede neural que controla a geração de imagens em Stable Diffusion adicionando condições extras. Detalhes podem ser encontrados no artigo Adding Conditional Control to Text-to-Image Diffusion Models por Lvmin Zhang e colaboradores.

É uma mudança de jogo. Você pode usar o ControlNet para, para citar alguns,

Neste post, você aprenderá tudo o que precisa saber sobre o ControlNet.

Este guia é para ControlNet com modelos Stable Diffusion v1.5. Veja o guia para ControlNet com modelos SDXL .

Stable Diffusion XL (SDXL) é o mais recente modelo de imagem de IA que pode gerar pessoas realistas, texto legível e diversos estilos de arte com excelente composição de imagem. É uma versão maior e melhor do celebrado modelo Stable Diffusion v1.5 , e daí o nome SDXL.

Conforme descrito no artigo “ SDXL: Melhorando modelos de difusão latente para síntese de imagens de alta resolução ” por Podell e colaboradores, o Stable Diffusion XL é em todos os aspectos melhor que o modelo v1.5.

As melhorias são

Este post abordará:

Instruct Pix2Pix é um modelo de Stable Diffusion que edita imagens apenas com instruções de texto do usuário. Veremos como ele funciona, o que ele pode fazer, como executá-lo na web e no AUTOMATIC1111, e como usá-lo.

Não é um artista nato? O Stable Diffusion pode ajudar. O Img2img (imagem para imagem) pode melhorar seu desenho, mantendo a cor e a composição.

Há uma postagem antiga no Reddit mostrando uma tarefa assustadora de remover a ex-esposa de uma foto de família. Certamente não consigo fazer isso com minha habilidade amadora no Photoshop. Mas isso foi antes da época da Stable Diffusion… Vamos descobrir o que podemos conseguir com o inpainting.

Neste post, vou mostrar como usar a função de pintura interna do Stable Diffusion para remover um objeto (uma pessoa neste caso) e reconstruir o fundo.

Desenvolver um processo para construir bons prompts é o primeiro passo que todo usuário do Stable Diffusion enfrenta. Este artigo resume o processo e as técnicas desenvolvidas por meio de experimentações e contribuições de outros usuários. O objetivo é escrever tudo o que sei sobre prompts para que você possa conhecê-los todos em um só lugar.

Você está procurando um gerador de imagens de IA gratuito online? Esta página fornece uma lista classificada de sites de terceiros que oferecem geração gratuita de imagens de Stable Diffusion e/ou Flux.

Abaixo estão algumas opções. Não sou afiliado a esses sites. Eu os classifico somente com base nos seguintes critérios.

Stable Diffusion é uma IA de texto para imagem que pode ser executada em computadores pessoais como Mac M1 ou M2. Neste artigo, você encontrará um guia passo a passo para instalar e executar o Stable Diffusion no Mac.

Nesse Tutorial vou ensinar para vocês como instalar o Stable Diffusion Automatic1111 no Windows. Para quem não conhece, o Stable Diffusion é um gerador de imagens que utiliza Inteligência Artificial para criar essas imagens bastando digitar o que você quer que ele crie, e ele criará automaticamente as imagens.

Essa versão do SD é a mais pura e compatível com Windows, mas se preferir também vou deixar no final do artigo o link para instalar a versão com apenas 1 click.

Link para o Tutorial no Youtube

A primeira coisa que iremos fazer é Baixar o Phyton e o Git.

Não vou colocar o link direto para os arquivos aqui, pois eles podem ser atualizados, então baixe sempre a versão que ele recomenda do Link Abaixo:

GitHub – AUTOMATIC1111/stable-diffusion-webui: Stable Diffusion web UI

Ao clicar no link acima irá abrir a página do repositório no GitHub, lá é o local certo e seguro para baixar o necessário.

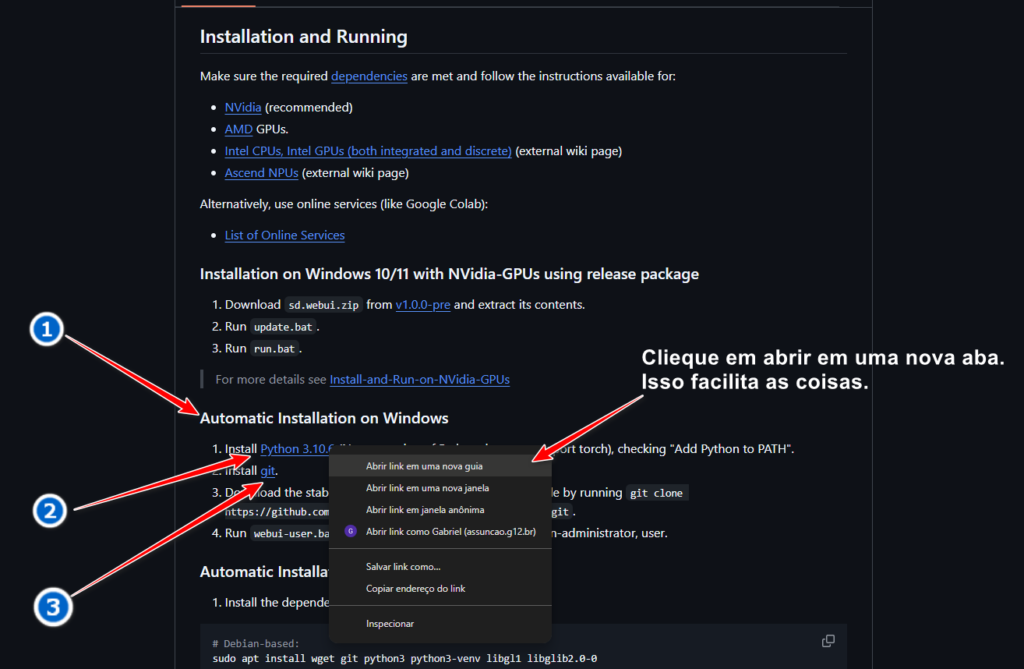

Vá descendo até chegar em Automatic Installation on Windows, como na imagem abaixo:

Clique com o botão direito do mouse em Python e dê Abrir em uma nova guia para ficar mais fácil a navegação, isso irá abrir a página em uma nova guia no navegador.

Faça o mesmo para o GIT.

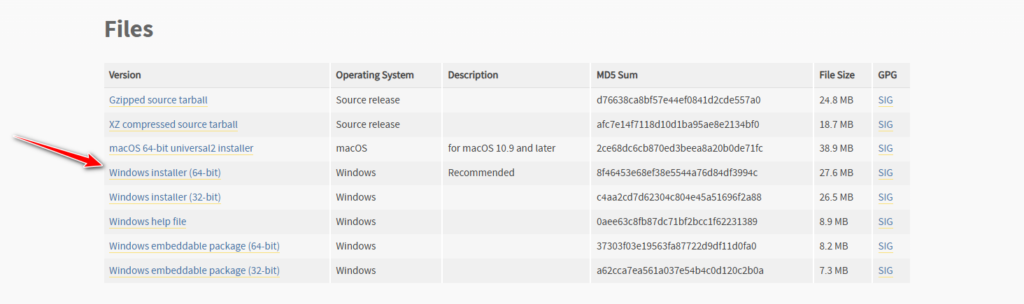

No Python baixe o arquivo Windows Installer (64 bit), como na imagem abaixo:

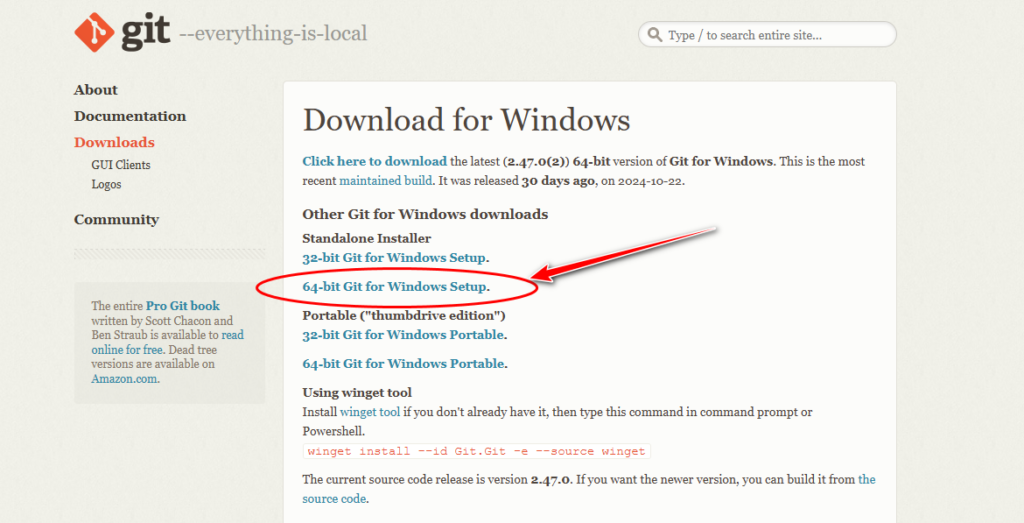

No GIT baixe o arquivo 64-bit Git for Windows Setup.

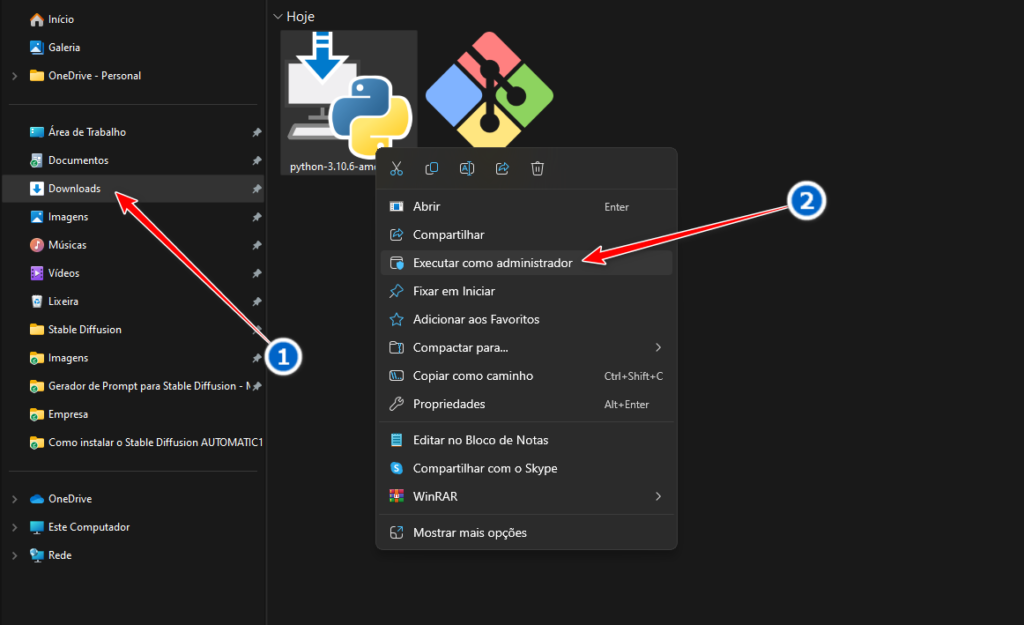

Após baixar os 2 arquivos, navegue até a pasta que você baixou, caso não saiba onde baixou, abra o Windows Explorer, por padrão ele será salvo na pasta Downloads, caso não ache onde baixou irá precisar baixar novamente e verificar onde está salvando.

Agora iremos instalar os 2 arquivos baixados, instale na sequência que for passado.

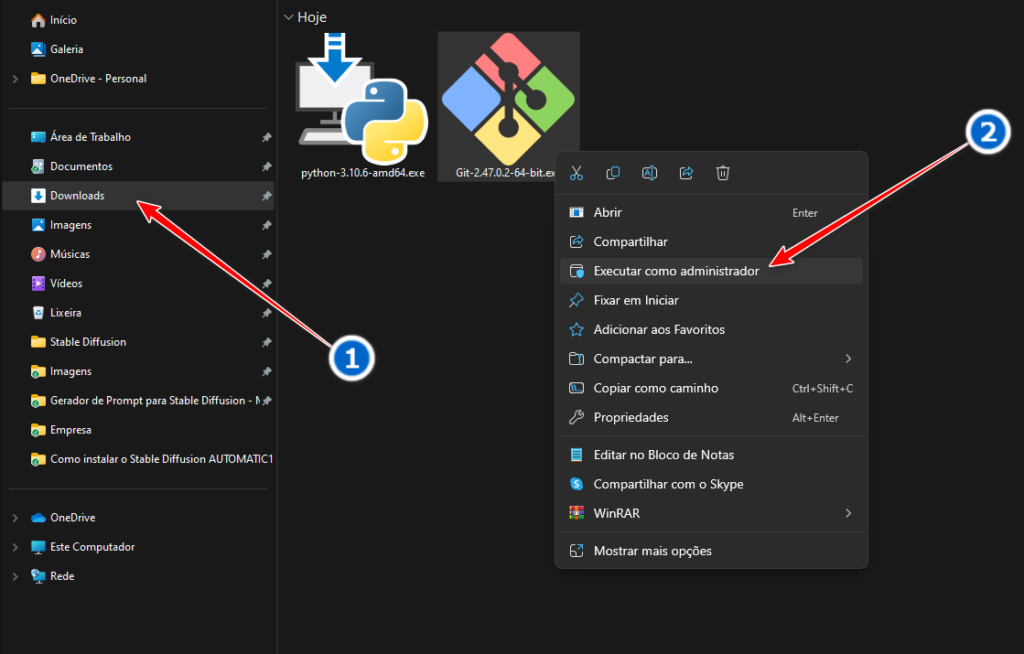

Primeiro deve ser instalado o Python, clique com o botão direito do mouse nele e clique em Executar como Administrador.

Caso dê algum erro ao abrir, leia a mensagem, mas provavelmente seja porque você tem uma outra versão do Phyton, caso isso ocorra você precisará desinstalar essa versão antes de instalar a que você baixou.

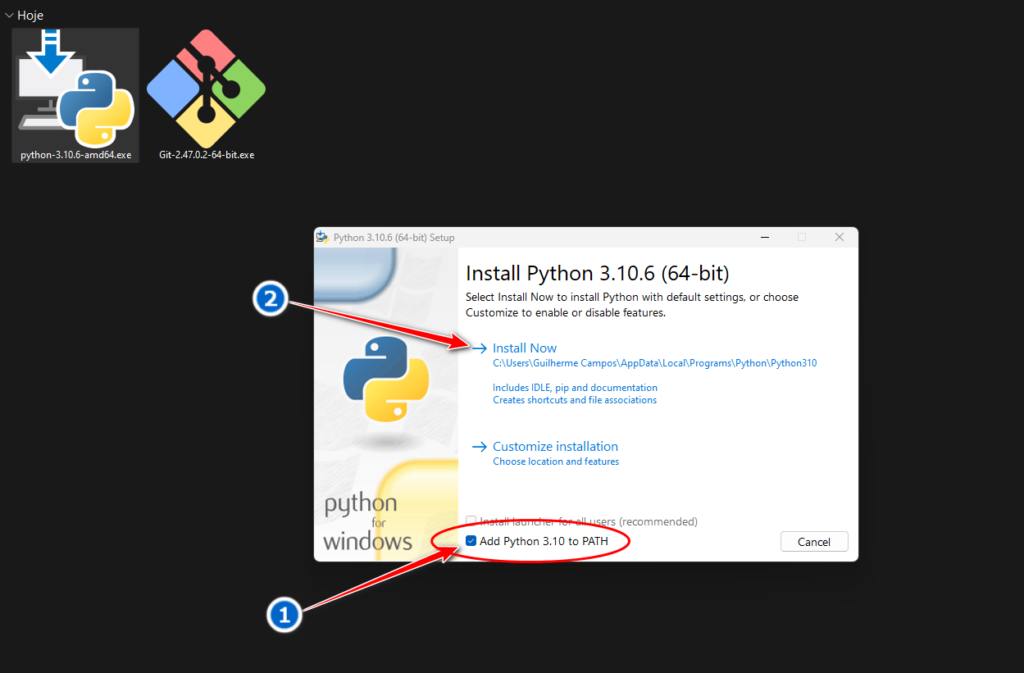

Ao abrir a Tela de instalação é EXTREMAMENTE IMPORTANTE selecionar ADD Phyton 3.10 to Path, depois clique em Install Now, como está na imagem abaixo:

Se você esqueceu de Deixar selecionado o ADD Phyton 3.10 to PATH, terá que instalar novamente, se não os comandos que iremos digitar depois não irão funcionar.

Depois do Python instalado corretamente, clique com o botão direito do mouse no arquivo do GIT e clique em Executar como Administrador.

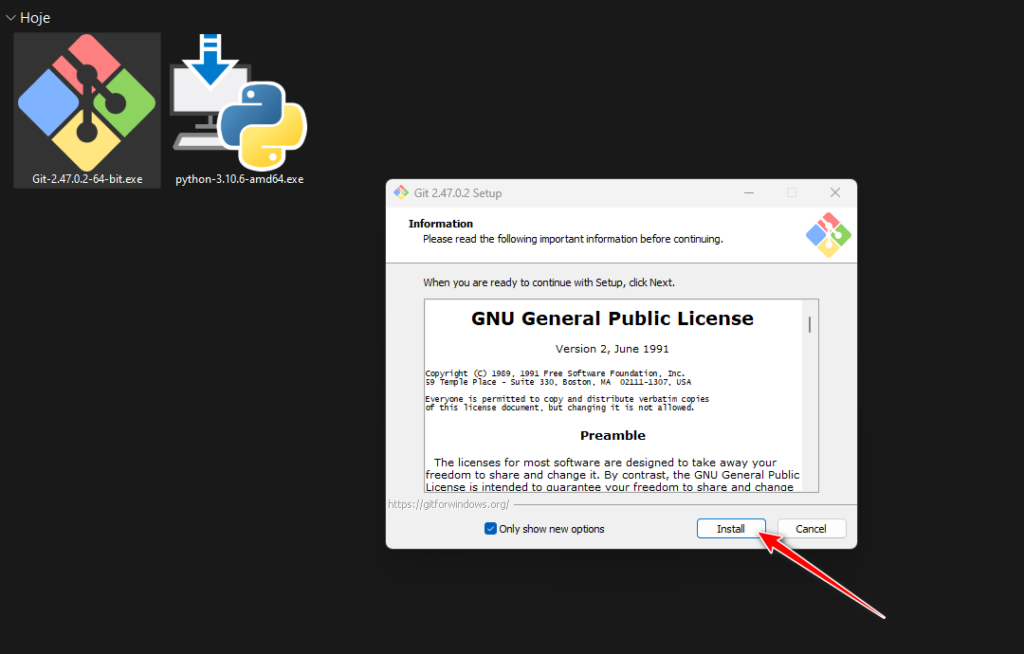

Com o instalador do GIT aberto clique em Install e vá apertando Next até terminar a instalação.

Agora iremos utilizar o terminal para instalar o Stable Diffusion Automatic1111.

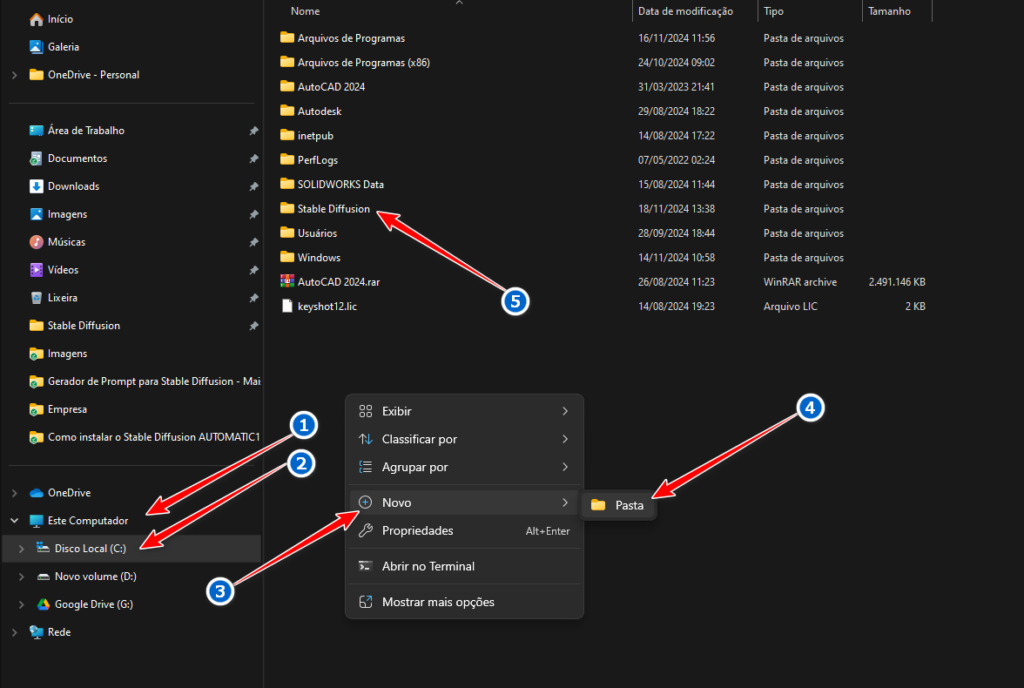

A primeira coisa a ser feita é criar uma pasta onde você quer que o seu programa fique.

É muito importante selecionar um HD ou SSD com bastante espaço, para que possa tirar todo proveito é necessário instalar Modelos, esses modelos possuem alguns GB de tamanho.

Para criar a pasta, abra o Explorador de Arquivos (Windows Explorer), você pode fazer isso clicando no botão iniciar do Windows e navegando até ele ou então apertando a tecla Windows + E.

Escolha o HD ou SSD onde vai instalar, no meu caso escolhi o C, depois clique em um local em branco com o botão direito do mouse, depois em Novo e Pasta. Dê um nome para a pasta, exemplo: Stable Diffusion, depois abra ela.

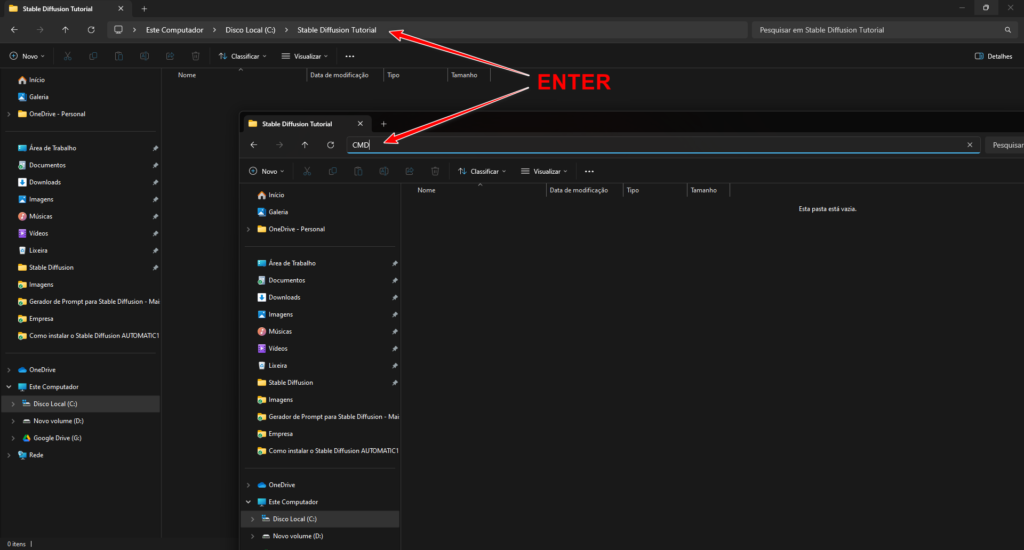

Dentro da pasta que você criou, clique na parte de cima da barra em uma parte em branco, apague o que está escrito e digite CMD e pressione ENTER.

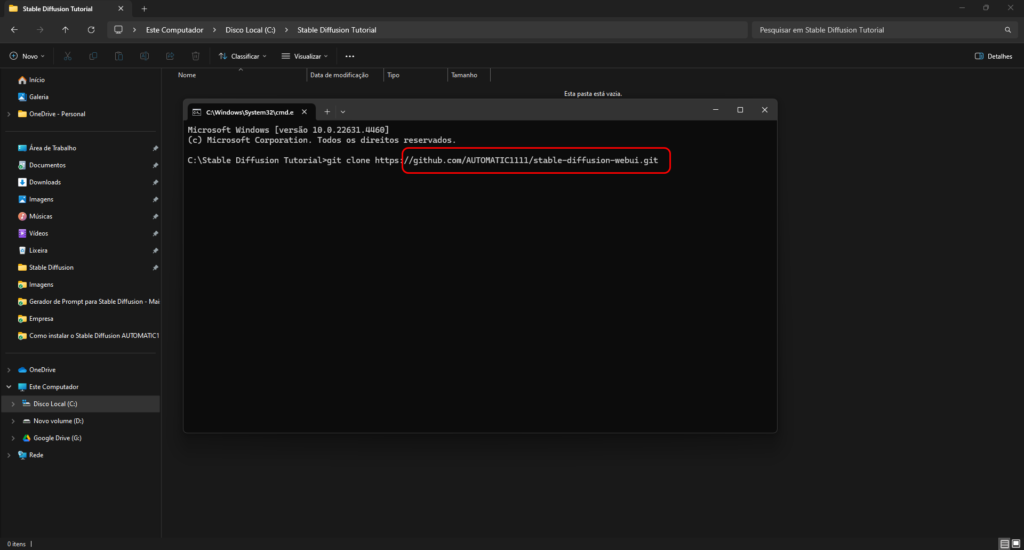

Com o CMD aberto digite ou cole o comando:

git clone https://github.com/AUTOMATIC1111/stable-diffusion-webui.git

Para colar o comando aperte CTRL + V, ou clique com o botão direito do mouse e depois pressione ENTER para ele instalar o Stable Diffusion Automatic1111 na pasta que você criou.

Se a sua internet for boa, após alguns segundos ele irá terminar de instalar o Stable Diffusion.

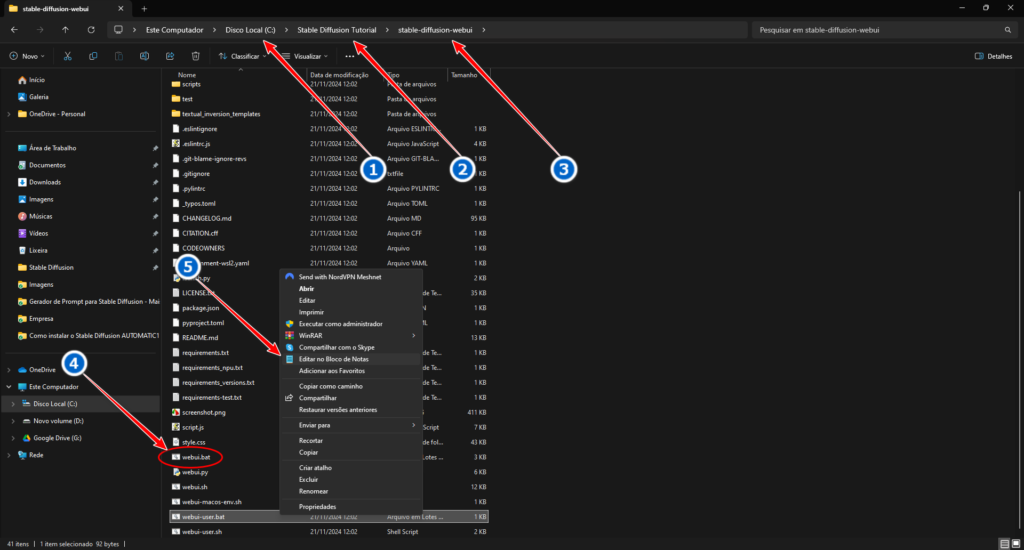

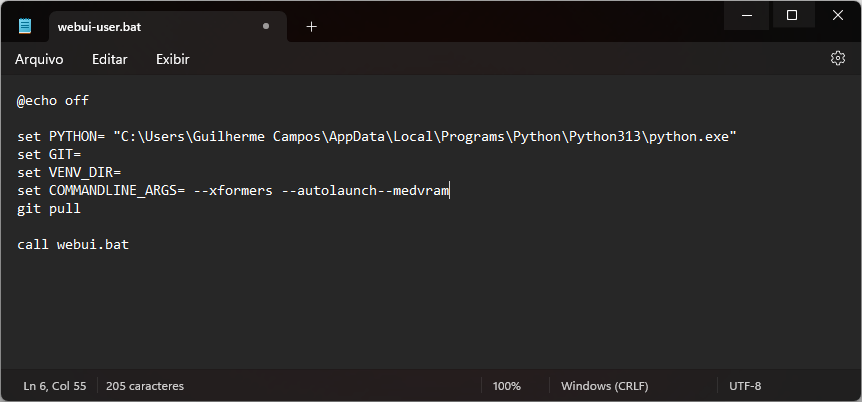

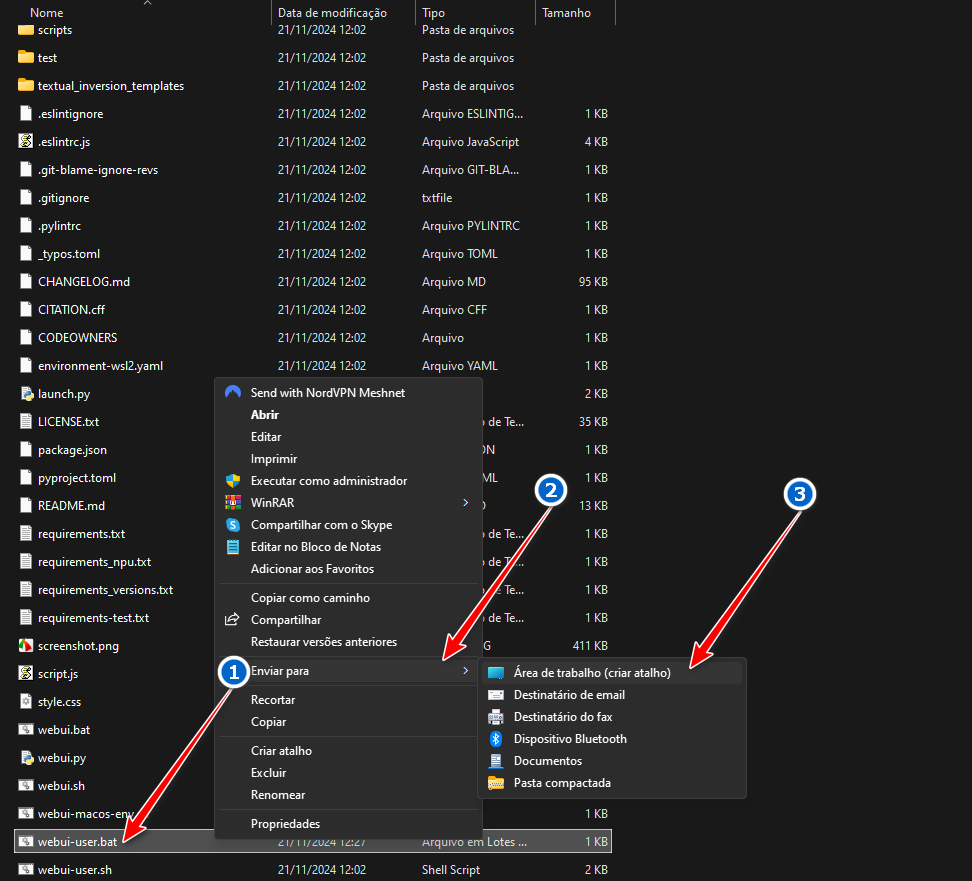

Dentro da pasta que você criou, ele irá criar outra pasta chamada stable-diffusion-webui, dentro desta pasta vá até o arquivo webui-user.bat, clique com o botão direito do mouse e clique em Editar ou Editar com o bloco de notas.

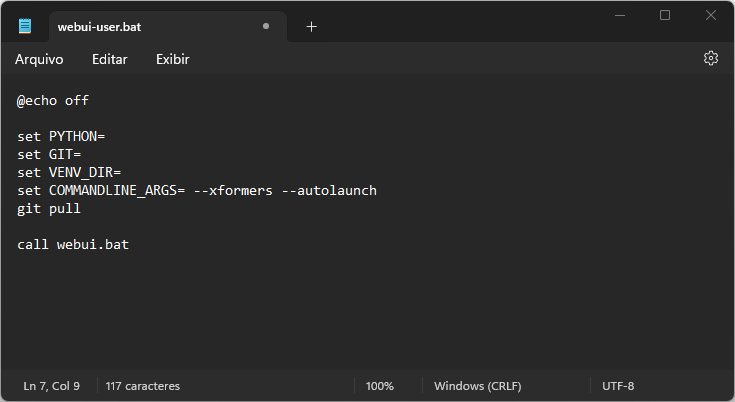

Com ele aberto você irá acrescentar na frente de set COMMANDLINE_ARGS os comandos:

--xformers --autolaunchAbaixo desse comando coloque a linha: git pull, para o Stable Diffusion ficar sempre atualizado.

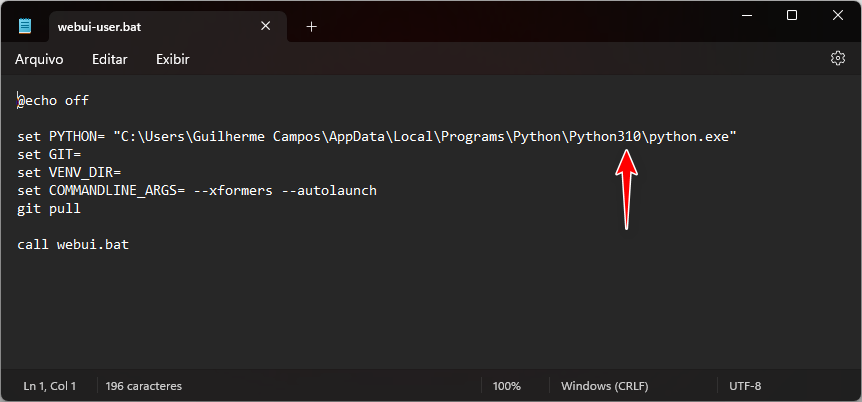

Deverá ficar igual a imagem:

Exemplo:

@echo off

set PYTHON=

set GIT=

set VENV_DIR=

set COMMANDLINE_ARGS= --xformers --autolaunch

git pull

call webui.batCaso você tenha mais de um Python instalado, precisará acrescentar o caminho do Python 3.10 para evitar dar problemas na hora de abrir o SD.

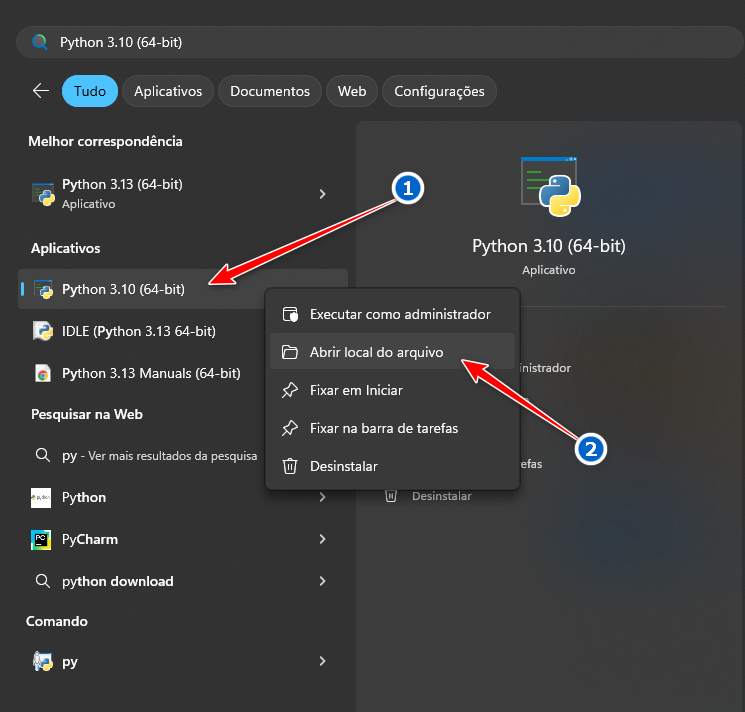

Como verificar se tem mais de 1 instalado, clique no botão iniciar do Windows e na barra de pesquisa digite: Python.

Todos Python instalados irão aparecer, clique com o botão direito do mouse em Python 3.10 e clique em Abrir local do arquivo.

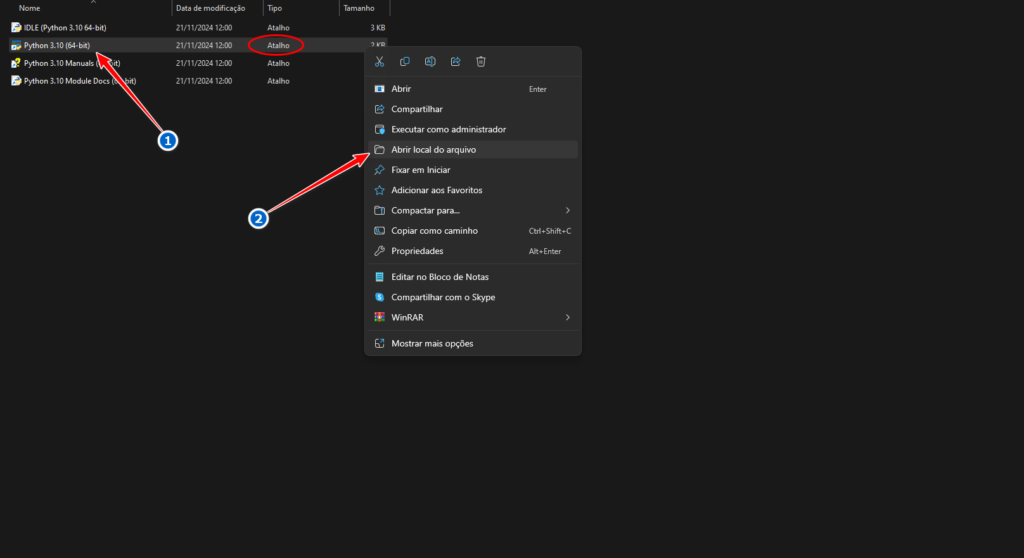

Ele irá abrir a pasta como na janela abaixo, essa pasta é onde estão os atalhos, não é esse local, como pode ver está escrito Atalho no Tipo, clique novamente com o botão direito e Abrir local do Arquivo.

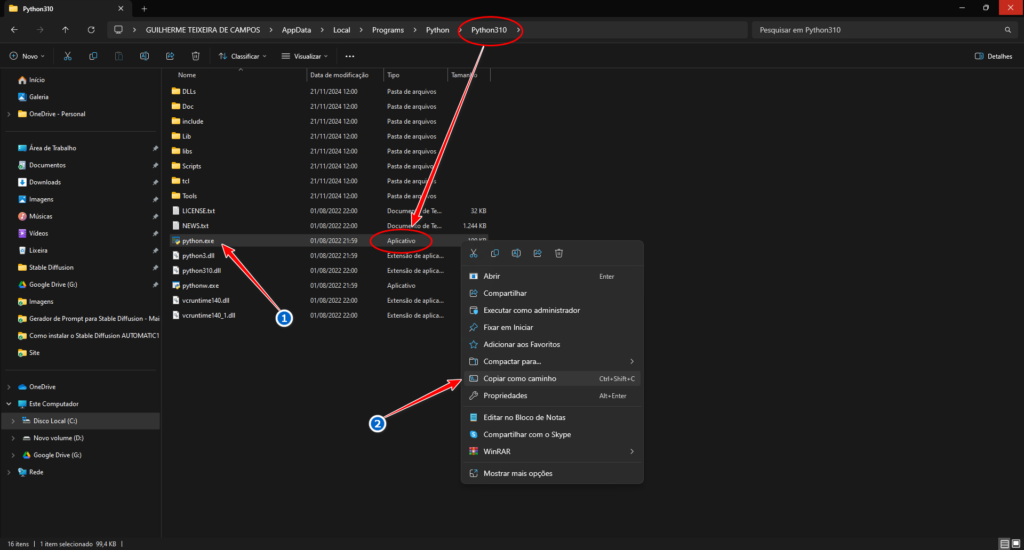

Esse é o local correto, como pode ver em Tipo está Aplicativo, clique com o direito em Python.exe e Clique em Copiar como Caminho.

Agora no arquivo webui-user.bat em set PYTHON= cole o caminho que você copiou do Python, é só dar CTRL+V na frente ou com o botão direito do mouse dê colar, ficará parecido com a imagem abaixo:

OBS: Se tiver menos de 8GB de VRAM na sua placa de vídeo, acrescente o comando no COMMANDLINE_ARGS:

--medvramMas só faça isso se realmente tiver menos de 8GB na sua placa de vídeo, pois isso deixará o SD mais lento, esse comando serve para economizar memória de vídeo e fazer ele rodar em placas mais fracas.

Então ficará parecido com os comandos abaixo:

Aqui tem a lista completa de comandos para o Stable Diffusion: Command Line Arguments and Settings

Agora é só executar o webui-user.bat sempre que for abrir o Stable Diffusion Automatic1111.

Para facilitar você pode clicar em Atalho clicando com o botão direito e depois em Enviar para a Área de trabalho, dessa forma ele irá criar um atalho na área de trabalho.

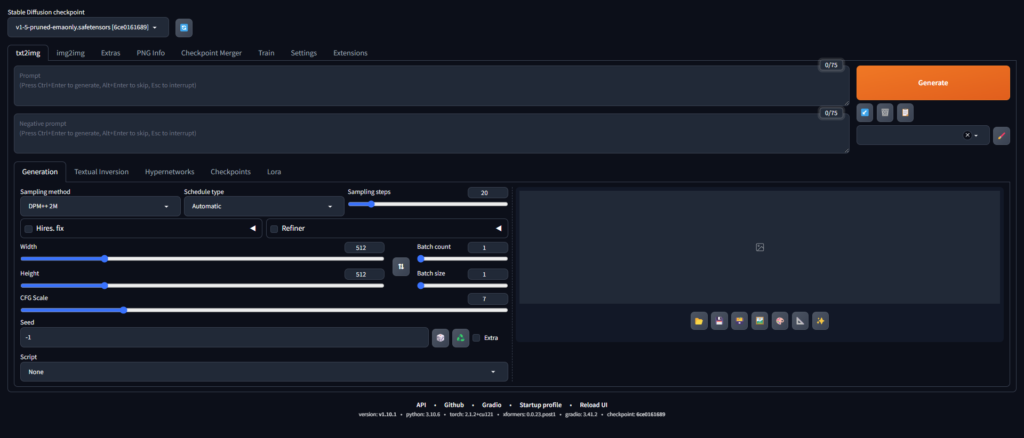

Quando executar o webui-user.bat ele irá carregar os arquivos necessários e quando estiver pronto irá abrir o Stable Diffusion Automatic1111 no navegador, como na imagem abaixo:

Pronto, agora o Stable Diffusion está instalado e pronto para utilizar! Essa maneira que mostrei de como instalar o SD é a mais pura e estável de todas, mas tem outras maneiras mais fáceis.

Se você não sabe como utilizar o Stable Diffusion, recomendo ver nossos próximos tutoriais!

POR FAVOR SE INSCREVAM NO CANAL DO YOUTUBE!

Link para o canal no Youtube: Realidade Artificial

Modelos de Stable Diffusion, ou modelos de checkpoint, são pesos do Stable Diffusion pré-treinados para gerar um estilo específico de imagens.

O tipo de imagem que um modelo gera depende das imagens de treinamento. Um modelo não será capaz de gerar uma imagem de gato se nunca houver um gato nos dados de treinamento. Da mesma forma, se você treinar um modelo apenas com imagens de gatos, ele gerará apenas gatos.

Apresentaremos o que são modelos, alguns populares e como instalá-los, usá-los e mesclá-los.

Não importa quão bons sejam seu prompt e modelo, é raro obter uma imagem perfeita em uma única foto.

Inpainting é uma maneira indispensável de consertar pequenos defeitos. Neste post, vou passar por alguns exemplos básicos de uso de inpainting para consertar defeitos.

Se você é novo em imagens de IA, talvez seja interessante ler primeiro o guia para iniciantes.

Esta é a parte 3 da série do guias para iniciantes.

Leia a parte 1: Guia para iniciantes absolutos

Leia a parte 2: Construção de prompts

Leia a parte 4: Modelos .

Usaremos Stable Diffusion AI e AUTOMATIC1111 GUI. Veja meu guia de início rápido para configuração no servidor de nuvem do Google.

Nesta seção, mostrarei passo a passo como usar o inpainting para corrigir pequenos defeitos.

Usarei uma imagem original do prompt do Lonely Palace :

[emma watson: amber hear: 0,5], (cabelo longo: 0,5), headLeaf, vestindo estola, vasto palácio romano, grande janela, palácio renascentista medieval, ((sala grande)), 4k, arstation, intrincado, elegante, altamente detalhado(Configurações detalhadas podem ser encontradas aqui .)

É uma boa imagem, mas gostaria de corrigir os seguintes problemas

Você sabia que existe um modelo de Difusão Estável treinado para inpainting? Você pode usá-lo se quiser obter o melhor resultado. Mas, normalmente, é OK usar o mesmo modelo com o qual você gerou a imagem para inpainting.

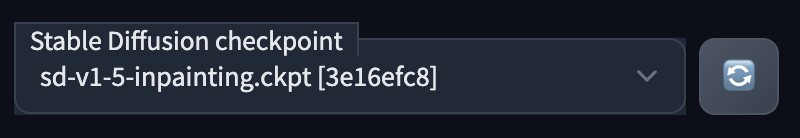

Para instalar o modelo de pintura v1.5 , baixe o arquivo de ponto de verificação do modelo e coloque-o na pasta

stable-diffusion-webui/models/Stable-diffusionNo AUTOMATIC1111, pressione o ícone de atualização ao lado da caixa suspensa de seleção de ponto de verificação no canto superior esquerdo. Selecione sd-v1-5-inpainting.ckptpara habilitar o modelo.

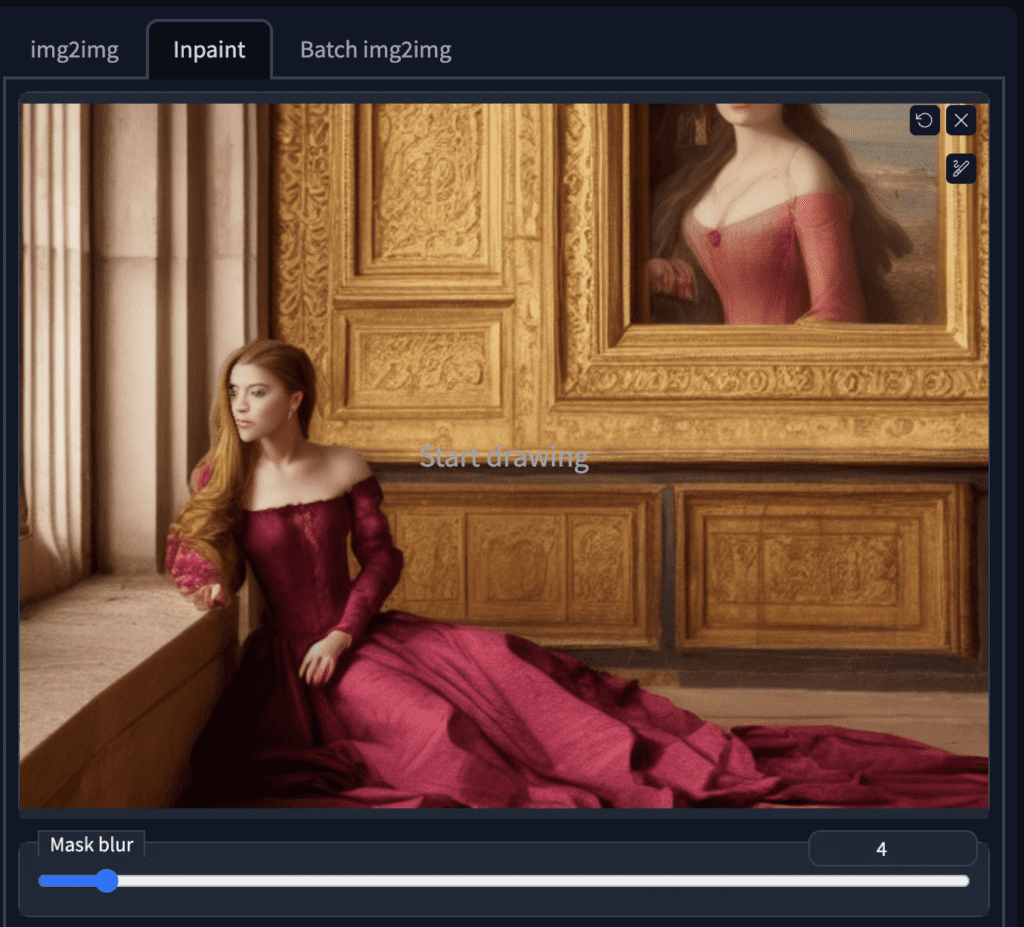

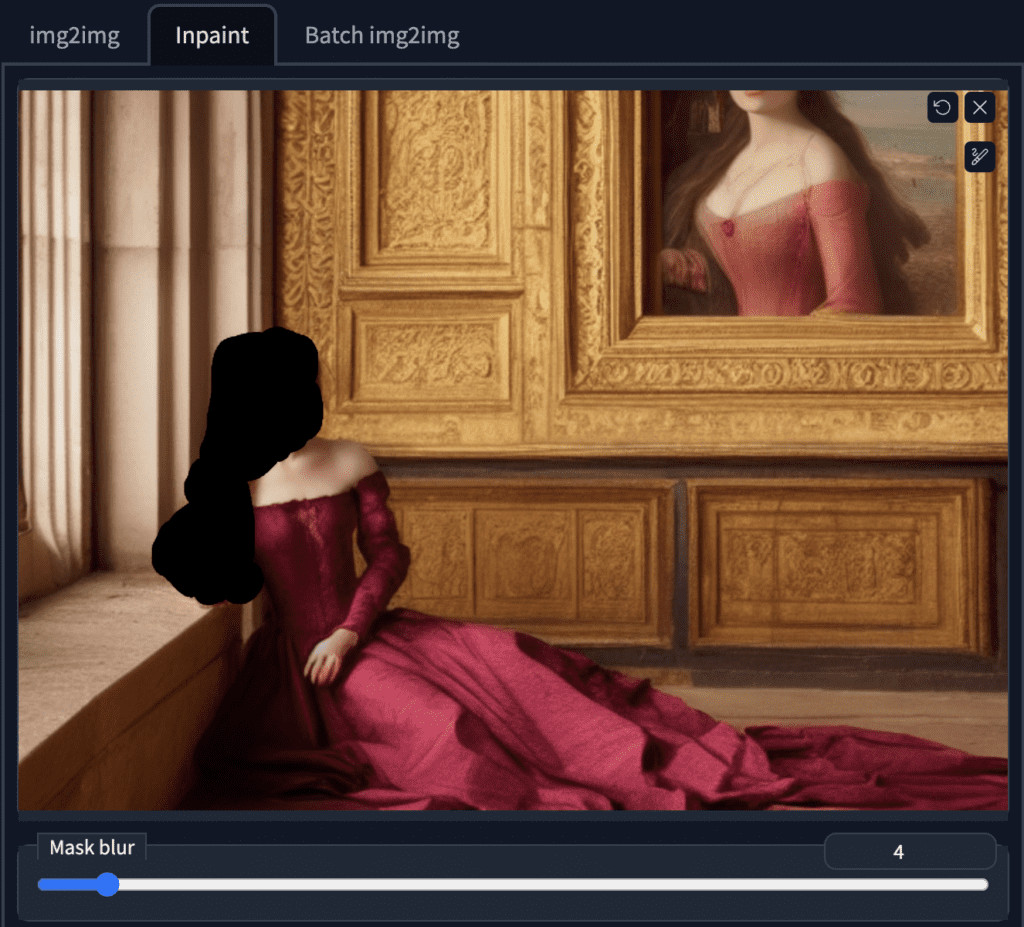

Na GUI do AUTOMATIC1111, selecione a aba img2img e selecione a subaba Inpaint . Carregue a imagem para a tela inpainting.

Vamos pintar o braço direito e o rosto ao mesmo tempo. Use a ferramenta pincel para criar uma máscara . Esta é a área em que você quer que o Stable Diffusion regenere a imagem.

Você pode reutilizar o prompt original para corrigir defeitos. Isso é como gerar múltiplas imagens, mas apenas em uma área específica.

O tamanho da imagem precisa ser ajustado para ser o mesmo da imagem original. (704 x 512 neste caso).

Se você estiver pintando rostos, você pode ativar a restauração de rostos . Você também precisará selecionar e aplicar o modelo de restauração de rosto a ser usado na aba Configurações . O CodeFormer é um bom.

Cuidado, pois esta opção pode gerar visuais não naturais. Também pode gerar algo inconsistente com o estilo do modelo.

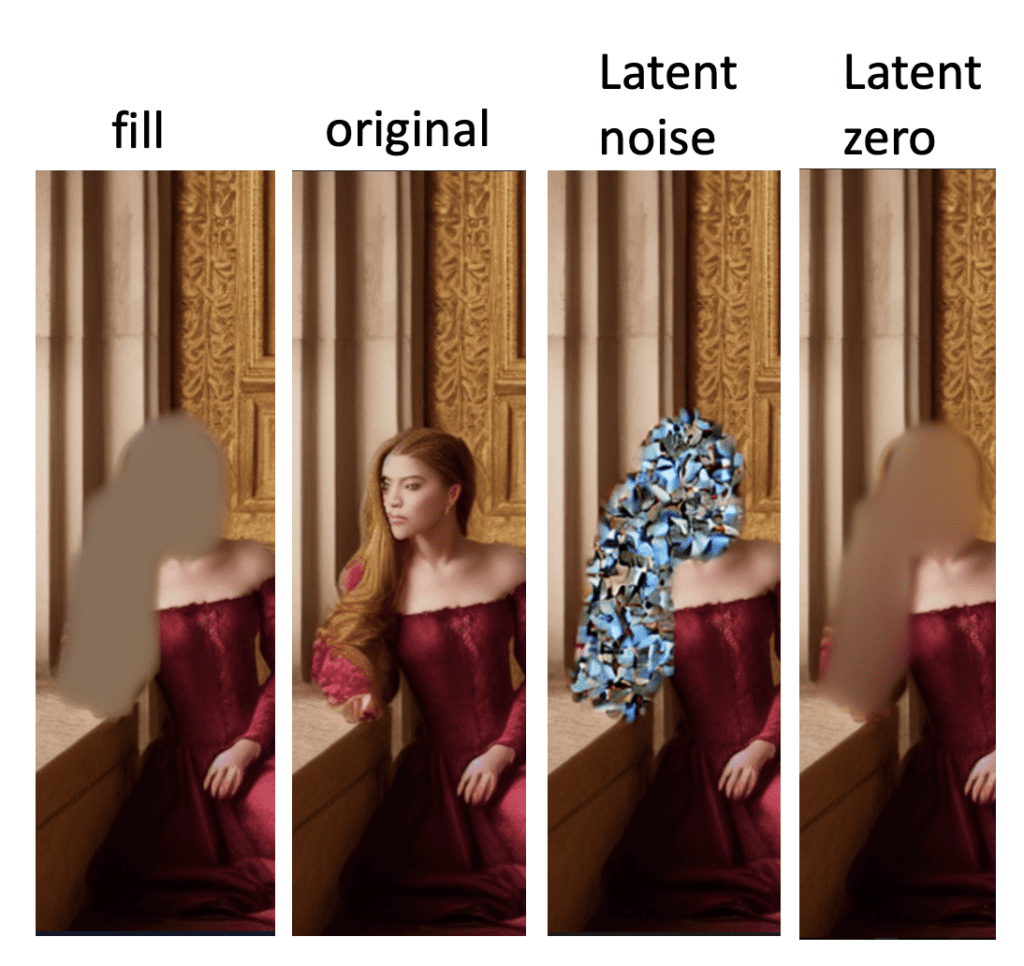

A próxima configuração importante é Conteúdo da Máscara .

Selecione original se quiser que o resultado seja guiado pela cor e forma do conteúdo original. Original é frequentemente usado ao pintar rostos porque a forma geral e a anatomia estavam ok. Queremos apenas que pareça um pouco diferente.

Na maioria dos casos, você usará o Original e alterará a intensidade da redução de ruído para obter efeitos diferentes.

Você pode usar latent noise ou latent nothing se quiser regenerar algo completamente diferente do original, por exemplo, remover um membro ou esconder uma mão. Essas opções inicializam a área mascarada com algo diferente da imagem original. Ela produzirá algo completamente diferente.

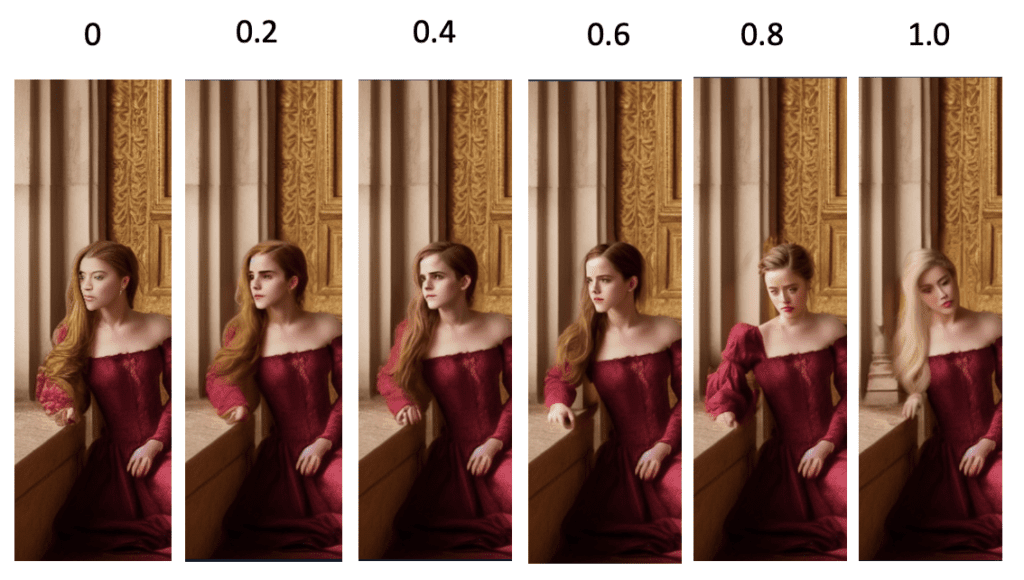

A intensidade do denoising controla quanta mudança ele fará em comparação com a imagem original. Nada mudará quando você definir como 0. Você obterá uma pintura interna não relacionada quando definir como 1.

0,75 geralmente é um bom ponto de partida. Diminua se quiser mudar menos.

Certifique-se de gerar algumas imagens por vez para que você possa escolher as melhores. Defina a semente para -1 para que cada imagem seja diferente.

| Prompt | (Igual ao original) |

| Etapas de amostragem | 20 |

| Seed | -1 |

| Tamanho da imagem | 704 x 512 |

| Restauração facial | Codeformer |

| Método de amostragem | Euler a |

| Modelo | Stable Diffusion v1.5 inpainting |

| Conteúdo da máscara | ruído latente ou nada latente |

| Inpaint em resolução máxima | On |

| Força de redução de ruído | 0,75 |

Abaixo estão algumas das imagens com inpainted aplicado.

Gosto do último, mas há uma mão extra sob o braço recém-pintado. Siga etapas semelhantes de upload desta imagem e criação de uma máscara. O conteúdo mascarado deve ser definido como ruído latente para gerar algo completamente diferente.

A mão sob o braço é removida com a segunda rodada de pintura:

E esta é minha imagem final.

Uma comparação lado a lado

Inpainting é um processo iterativo. Você pode aplicá-lo quantas vezes quiser para refinar uma imagem.

Veja esta postagem para outro exemplo mais extremo de inpainting.

Veja o tutorial para remover membros extras com pintura interna .

Às vezes você quer adicionar algo novo à imagem.

Vamos tentar adicionar um leque à imagem.

Primeiro, carregue a imagem na tela de pintura e crie uma máscara ao redor do peito e do braço direito.

Adicione o prompt “segurando um leque de mão” ao início do prompt original. O prompt para inpainting é

(segurando um leque: 1,2), [emma watson: âmbar ouvido: 0,5], (cabelo longo: 0,5), headLeaf, vestindo estola, vasto palácio romano, grande janela, palácio renascentista medieval, ((sala grande)), 4k, arstation, intrincado, elegante, altamente detalhado

Adicionar novos objetos ao prompt original garante consistência no estilo. Você pode ajustar o peso da palavra-chave (1.2 acima) para fazer o leque aparecer.

Defina o conteúdo mascarado como ruído latente .

Ajuste a intensidade da redução de ruído e a escala CFG para refinar as imagens pintadas.

Depois de alguma experimentação, nossa missão foi cumprida:

A intensidade do denoising controla o quanto a imagem final deve respeitar o conteúdo original. Definindo como 0 não muda nada. Definindo como 1, você tem uma imagem não relacionada.

Defina um valor baixo se quiser uma pequena mudança e um valor alto se quiser uma grande mudança.

Semelhante ao uso em texto para imagem , a escala de Orientação Livre do Classificador é um parâmetro para controlar o quanto o modelo deve respeitar seu prompt.

1 – Ignore principalmente seu prompt.

3 – Seja mais criativo.

7 – Um bom equilíbrio entre seguir o prompt e a liberdade.

15 – Aderir mais ao prompt.

30 – Siga o prompt rigorosamente.

O conteúdo mascarado controla como a área mascarada é inicializada.

Abaixo estão os conteúdos iniciais da máscara antes de quaisquer etapas de amostragem. Isso dá a você uma ideia do que eles são.

A pintura interna bem-sucedida requer paciência e habilidade. Aqui estão algumas dicas para usar a pintura interna

Confira o Curso de Difusão Estável para um curso guiado passo a passo.

Ou continue para a parte 4 abaixo.

Esta é a parte 3 da série de guias para iniciantes.

Leia a parte 1: Guia para iniciantes absolutos .

Leia a parte 2: Construção de prompts .

Leia a parte 4: Modelos .